- はじめに(last modified 2014/05/14)

- 過去のお知らせ(last modified 2022/10/26)

- インストール | について (last modified 2015/04/02)

- インストール | R本体 | 最新版 | Win用 (last modified 2015/03/22)推奨

- インストール | R本体 | 最新版 | Mac用 (last modified 2015/04/01)推奨

- インストール | R本体 | 過去版 | Win用 (last modified 2015/03/22)

- インストール | R本体 | 過去版 | Mac用 (last modified 2015/03/22)

- インストール | Rパッケージ | ほぼ全て(20GB以上?!) (last modified 2015/03/22)

- インストール | Rパッケージ | 必要最小限プラスアルファ(数GB?!) (last modified 2017/03/08)推奨

- インストール | Rパッケージ | 必要最小限(数GB?!) (last modified 2015/05/25)

- インストール | Rパッケージ | 個別 (last modified 2015/10/17)

- (削除予定)Rのインストールと起動(last modified 2014/05/14)

- (削除予定)Rの昔のバージョンのインストール(last modified 2012/04/07)

- 使用例(初心者向け)(last modified 2011/09/15)

- サンプルデータ (last modified 2017/03/10)

- イントロ | 発現データ取得 | 公共DBから (last modified 2014/05/11)

- イントロ | 発現データ取得 | inSilicoDb(Taminau_2011) (last modified 2015/05/11)

- イントロ | 発現データ取得 | ArrayExpress(Kauffmann_2009) (last modified 2015/05/11)推奨

- イントロ | 発現データ取得 | GEOquery(Davis_2007) (last modified 2013/08/20)

- イントロ | アノテーション情報取得 | 公共DB(GEO)から (last modified 2013/08/18)

- イントロ | アノテーション情報取得 | GEOquery(Davis_2007) (last modified 2017/03/08)推奨

- イントロ | アノテーション情報取得 | Rのパッケージ*.dbから (last modified 2014/06/02)

- イントロ | プローブ配列情報取得 | Rのパッケージから (last modified 2013/08/16)

- イントロ | トランスクリプトーム配列取得 | biomaRt(Durinck_2009) (last modified 2013/09/18)推奨

- イントロ | トランスクリプトーム配列取得 | annotateパッケージ (last modified 2013/09/25)

- イントロ | Affymetrix CELファイル | 各種情報取得 (last modified 2013/09/04)

- 正規化(cDNA or two-color or 二色法) について(last modified 2008/03/31)

- 正規化 | Stanford型 (or cDNA)マイクロアレイ (package: limma)

- 正規化 | Stanford型 (or cDNA)マイクロアレイ (package: marray)

- 正規化 | Agilent microarray | について(last modified 2014/07/24)

- 正規化 | Agilent microarray | agilp(Chain_2010) (last modified 2013/05/30)

- 正規化 | Illumina BeadArray | について(last modified 2014/07/16)

- 正規化 | Illumina BeadArray | BeadDataPackR(Smith_2010) (last modified 2013/05/30)

- 正規化 | Illumina BeadArray | lumi(Du_2008) (last modified 2013/05/30)

- 正規化 | Illumina BeadArray | beadarray(Dunning_2007) (last modified 2013/05/30)

- 正規化 | Affymetrix GeneChip | について(last modified 2015/11/11)

- 正規化 | Affymetrix GeneChip | frma(McCall_2010) (last modified 2013/08/21)

- 正規化 | Affymetrix GeneChip | rmx(Kohl_2010) (last modified 2016/05/10)

- 正規化 | Affymetrix GeneChip | GRSN(Pelz_2008) (last modified 2013/05/27)

- 正規化 | Affymetrix GeneChip | Hook(Binder_2008) (last modified 2013/05/30)

- 正規化 | Affymetrix GeneChip | DFW(Chen_2007) (last modified 2022/04/17)

- 正規化 | Affymetrix GeneChip | FARMS(Hochreiter_2006) (last modified 2019/12/28)

- 正規化 | Affymetrix GeneChip | multi-mgMOS(Liu_2005) (last modified 2013/08/21)

- 正規化 | Affymetrix GeneChip | GCRMA(Wu_2004) (last modified 2013/08/21)

- 正規化 | Affymetrix GeneChip | PLIER(Affymetrix_2004) (last modified 2013/08/21)

- 正規化 | Affymetrix GeneChip | VSN(Huber_2002) (last modified 2013/08/21)

- 正規化 | Affymetrix GeneChip | RMA(Irizarry_2003) (last modified 2013/08/21)推奨

- 正規化 | Affymetrix GeneChip | MAS5.0(Hubbell_2002) (last modified 2013/11/25)

- 正規化 | Affymetrix GeneChip | MBEI(Li_2001) (last modified 2013/08/21)

- 前処理 | について(last modified 2013/11/13)

- 前処理 | スケーリング | サンプル間のシグナル強度の平均値をそろえる (last modified 2013/6/2)

- 前処理 | スケーリング | サンプル間のシグナル強度の中央値をそろえる (last modified 2013/6/2)

- 前処理 | スケーリング | 各サンプルのシグナル強度の平均を0、標準偏差を1にする (last modified 2013/6/2)

- 前処理 | スケーリング | 各遺伝子のシグナル強度の平均を0、標準偏差を1にする (last modified 2013/6/2)

- 前処理 | スケーリング | 各サンプル or 遺伝子のシグナル強度の平均を0、MADを1にする (last modified 2013/6/2)

- 前処理 | スケーリング | 各サンプル or 遺伝子のシグナル強度の中央値を0、標準偏差を1にする (last modified 2013/6/2)

- 前処理 | スケーリング | 各サンプル or 遺伝子のシグナル強度の中央値を0、MADを1にする (last modified 2013/6/2)

- 前処理 | スケーリング | 各サンプル or 遺伝子のシグナル強度のTukey biweightを0、MADを1にする (last modified 2013/6/2)

- 前処理 | スケーリング | 各サンプル or 遺伝子のシグナル強度の範囲を0-1にする (last modified 2013/6/2)

- 前処理 | スケーリング | シグナル強度を対数(log)変換する (last modified 2013/6/2)

- 前処理 | スケーリング | Quantile normalization(last modified 2013/09/11)

- 前処理 | フィルタリング | 低発現遺伝子を除去 (last modified 2013/11/14)

- 前処理 | フィルタリング | log比が小さいものを除去 (last modified 2013/11/15)

- 前処理 | フィルタリング | NAを含むものを除去 (last modified 2013/11/15)

- 前処理 | フィルタリング | CVが小さいものを除去 (last modified 2013/11/15)

- 前処理 | フィルタリング | 分散が小さいものを除去 (last modified 2013/11/15)

- 前処理 | ID変換 | について(last modified 2014/06/03)

- 前処理 | ID変換 | probe ID --> gene symbol(last modified 2017/09/22)

- 前処理 | ID変換 | probe ID --> Entrez ID(last modified 2014/06/03)

- 前処理 | ID変換 | probe ID --> その他(last modified 2014/06/03)

- 前処理 | ID変換 | 同じ遺伝子名を持つものをまとめる(last modified 2014/06/02)

- 解析 | 基礎 | 共通遺伝子の抽出(last modified 2013/06/02)

- 解析 | 基礎 | ベクトル間の距離(last modified 2013/11/22)

- 解析 | 基礎 | 遺伝子ごとの各種要約統計量の算出(last modified 2013/06/02)

- 解析 | 基礎 | 最大発現量を示す組織の同定(last modified 2013/06/02)

- 解析 | 基礎 | 似た発現パターンを持つ遺伝子の同定 (last modified 2013/06/02)

- 解析 | 基礎 | 平均-分散プロット (last modified 2013/11/25)

- 解析 | クラスタリング | について (last modified 2015/11/11)

- 解析 | クラスタリング | 階層的 | について (last modified 2016/05/25)

- 解析 | クラスタリング | 階層的 | pvclust (Suzuki_2006) (last modified 2010/08/05)

- 解析 | クラスタリング | 階層的 | hclust (last modified 2014/05/17)

- 解析 | クラスタリング | 階層的 | hclust後の詳細な解析 (last modified 2009/08/07)

- 解析 | クラスタリング | 階層的 | 最適なクラスター数を見積る (last modified 2009/09/09)

- 解析 | クラスタリング | 非階層的 | について (last modified 2015/11/11)

- 解析 | クラスタリング | 非階層的 | K-means

- 解析 | クラスタリング | 非階層的 | 自己組織化マップ(SOM)

- 解析 | クラスタリング | 非階層的 | 主成分分析(PCA) (last modified 2012/04/13)

- 解析 | 発現変動 | 2群間 | 発現変動遺伝子の割合を調べる | OCplus(Ploner_2006) (last modified 2015/11/11)

- 解析 | 発現変動 | 2群間 | 対応なし | について (last modified 2015/11/11)

- 解析 | 発現変動 | 2群間 | 対応なし | RankProd 2.0 (Del Carratore_2017) (last modified 2019/03/16)

- 解析 | 発現変動 | 2群間 | 対応なし | WAD (Kadota_2008) (last modified 2015/03/30)

- 解析 | 発現変動 | 2群間 | 対応なし | Random forest (Diaz-Uriarte_2007) (last modified 2013/06/02)

- 解析 | 発現変動 | 2群間 | 対応なし | shrinkage t (Opgen-Rhein_2007) (last modified 2013/06/02)

- 解析 | 発現変動 | 2群間 | 対応なし | layer ranking algorithm (Chen_2007) (last modified 2013/06/02)

- 解析 | 発現変動 | 2群間 | 対応なし | fdr2d (Ploner_2006) (last modified 2013/06/02)

- 解析 | 発現変動 | 2群間 | 対応なし | IBMT (Sartor_2006) (last modified 2014/02/03)

- 解析 | 発現変動 | 2群間 | 対応なし | Rank products (Breitling_2004) (last modified 2016/08/30)非推奨

- 解析 | 発現変動 | 2群間 | 対応なし | empirical Bayes (Smyth_2004) (last modified 2016/05/19)

- 解析 | 発現変動 | 2群間 | 対応なし | samroc (Broberg_2003) (last modified 2014/02/03)

- 解析 | 発現変動 | 2群間 | 対応なし | SAM (Tusher_2001) (last modified 2014/02/03)

- 解析 | 発現変動 | 2群間 | 対応なし | Student's t-test(last modified 2014/05/25)

- 解析 | 発現変動 | 2群間 | 対応なし | Welch t-test(last modified 2014/05/23)

- 解析 | 発現変動 | 2群間 | 対応なし | Mann-Whitney U-test(last modified 2013/10/15)

- 解析 | 発現変動 | 2群間 | 対応なし | パターンマッチング法(last modified 2014/05/23)

- 解析 | 発現変動 | 2群間 | 対応あり | について(last modified 2009/11/11)

- 解析 | 発現変動 | 2群間 | 対応あり | SAM (Tusher_2001) (last modified 2014/06/02)

- 解析 | 発現変動 | 2群間 | 対応あり | SAM (Tusher_2001)+WADの重みづけ (last modified 2013/06/02)

- 解析 | 発現変動 | 2群間 | 対応あり | 時系列 |について(last modified 2013/6/8)

- 解析 | 発現変動 | 2群間 | 対応あり | 時系列 | maSigPro (Conesa_2006) (last modified 2013/6/2)

- 解析 | 発現変動 | 3群間 | 対応なし | について(last modified 2015/01/16)

- 解析 | 発現変動 | 3群間 | 対応なし | Mulcom (Isella_2011)(last modified 2013/12/06)

- 解析 | 発現変動 | 3群間 | 対応なし | 基礎 | limma (Ritchie_2015)(last modified 2015/06/08)

- 解析 | 発現変動 | 3群間 | 対応なし | 応用1 | limma (Ritchie_2015)(last modified 2015/06/08)

- 解析 | 発現変動 | 3群間 | 対応なし | 応用2 | limma (Smyth_2004)(last modified 2015/06/08)

- 解析 | 発現変動 | 3群間 | 対応なし | 一元配置分散分析(One-way ANOVA)(last modified 2013/11/12)

- 解析 | 発現変動 | 3群間 | 対応なし | Kruskal-Wallis(クラスカル-ウォリス)検定 (last modified 2013/6/2)

- 解析 | 発現変動 | 多群間 | について(last modified 2013/6/2)

- 解析 | 発現変動 | 多群間 | SpeCond(Cavalli_2011) (last modified 2013/6/10)

- 解析 | 発現変動 | 多群間 | ROKU(Kadota_2006) (last modified 2014/05/30)

- 解析 | 発現変動 | 多群間 | Sprent's non-parametric method(Ge_2005) (last modified 2009/07/31)

- 解析 | 発現変動 | 多群間 | Schug's H(x) statistic(Schug_2005) (last modified 2011/10/13)

- 解析 | 発現変動 | 多群間 | Schug's Q statistic(Schug_2005) (last modified 2009/07/31)

- 解析 | 発現変動 | 多群間 | Ueda's AIC-based method(Kadota_2003) (last modified 2009/07/31)

- 解析 | 発現変動 | 多群間 | パターンマッチング法(テンプレートマッチング法) (last modified 2012/05/28)

- 解析 | 発現変動 | 時系列 | について(last modified 2013/6/10)

- 解析 | 発現変動 | 時系列 | Periodic genes | M-estimator (Ahdesmaki_2007) (last modified 2009/8/3)

- 解析 | 発現変動 | 時系列 | Periodic genes | Lomb-Scargle periodogram (Glynn_2006) (last modified 2006/7/11)

- 解析 | 発現変動 | 時系列 | non-periodic genes | randomized BHC (Darkins_2013) (last modified 2013/6/10)

- 解析 | 発現変動 | 時系列 | non-periodic genes | IPCA (Yao_2012) (last modified 2013/6/10)

- 解析 | 発現変動 | 時系列 | non-periodic genes | gptk (Kalaitzis_2011) (last modified 2013/6/10)

- 解析 | 発現変動 | 時系列 | non-periodic genes | betr (Aryee_2009) (last modified 2012/05/29)

- 解析 | 発現変動 | 時系列 | non-periodic genes | maSigPro (Conesa_2006) (last modified 2015/08/16)

- 解析 | 発現変動 | 時系列 | non-periodic genes | SAM (Tusher_2001) (last modified 2015/08/16)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | について(last modified 2018/06/22)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | GSAR (Rahmatallah_2017)(last modified 2017/05/11)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | gage (Luo_2009)(last modified 2015/05/25)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | GSA (Efron_2007)(last modified 2017/03/07)推奨

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | Category (Jiang_2007)(last modified 2014/06/01)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | pcot2 (Kong_2006)(last modified 2014/06/01)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | SAFE (Barry_2005)(last modified 2014/06/01)

- 解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | globaltest (Goeman_2004)(last modified 2014/06/01)

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | について(last modified 2018/06/22)

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | GSAR (Rahmatallah_2017)(last modified 2017/03/12)

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | Pathview (Luo_2013)(last modified 2014/06/01)

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | gage (Luo_2009)(last modified 2016/05/25)

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | SPIA (Tarca_2009)(last modified 2014/06/01)

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | GSA (Efron_2007)(last modified 2017/03/08)推奨

- 解析 | 機能解析 | パスウェイ(Pathway)解析 | sigPathway (Tian_2005)(last modified 2014/06/01)

- ...

- 解析 | 機能解析(GSEA周辺)について(以下は再編予定)(last modified 2014/06/01)

- 解析 | 機能解析 | PAGE法(Kim_2005;統計量の変換なし)の考え方について (last modified 2009/9/11)

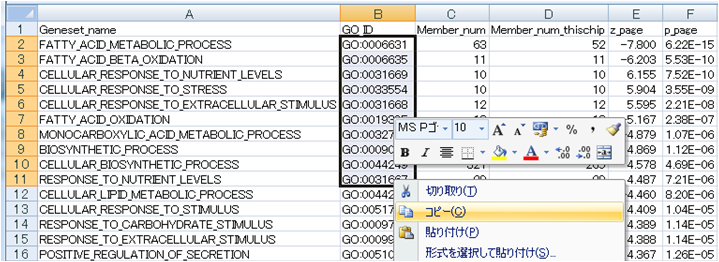

- 解析 | 機能解析 | PAGE法(Kim_2005;統計量の変換なし)を用いてGene Ontology解析 (last modified 2009/11/19)

- 解析 | 機能解析 | PAGE法(Kim_2005;統計量の変換あり)を用いてGene Ontology解析 (last modified 2009/10/27)

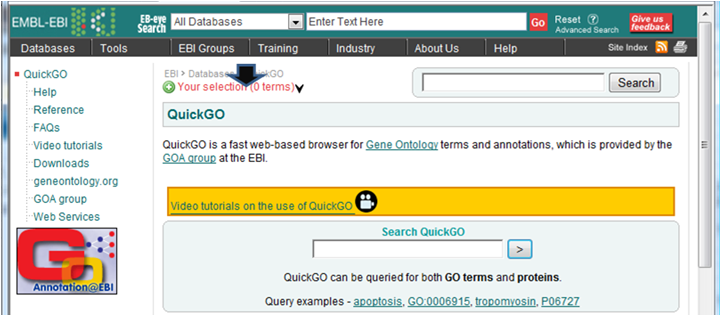

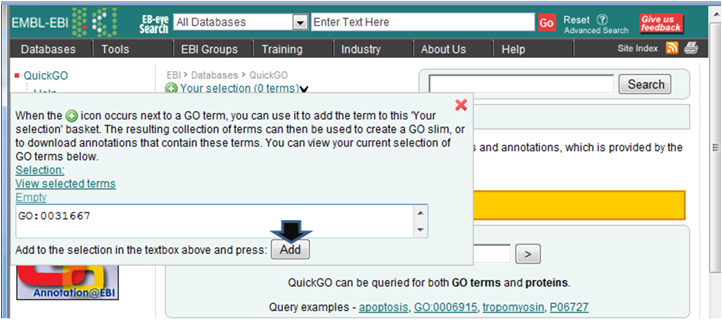

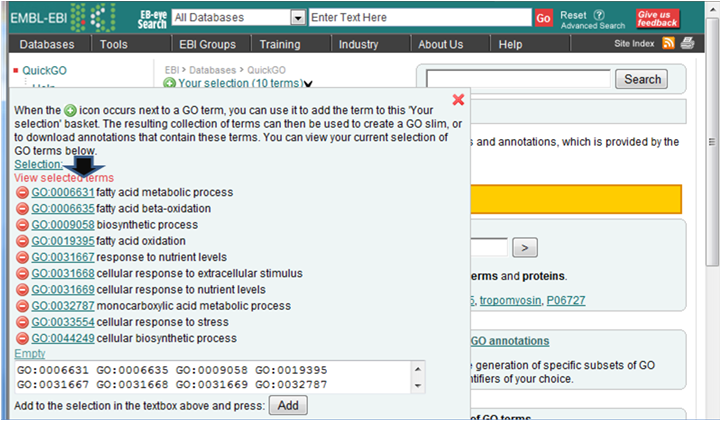

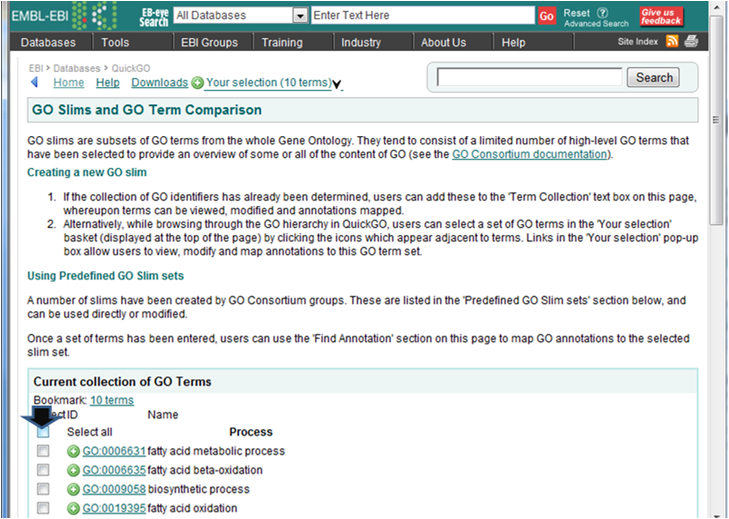

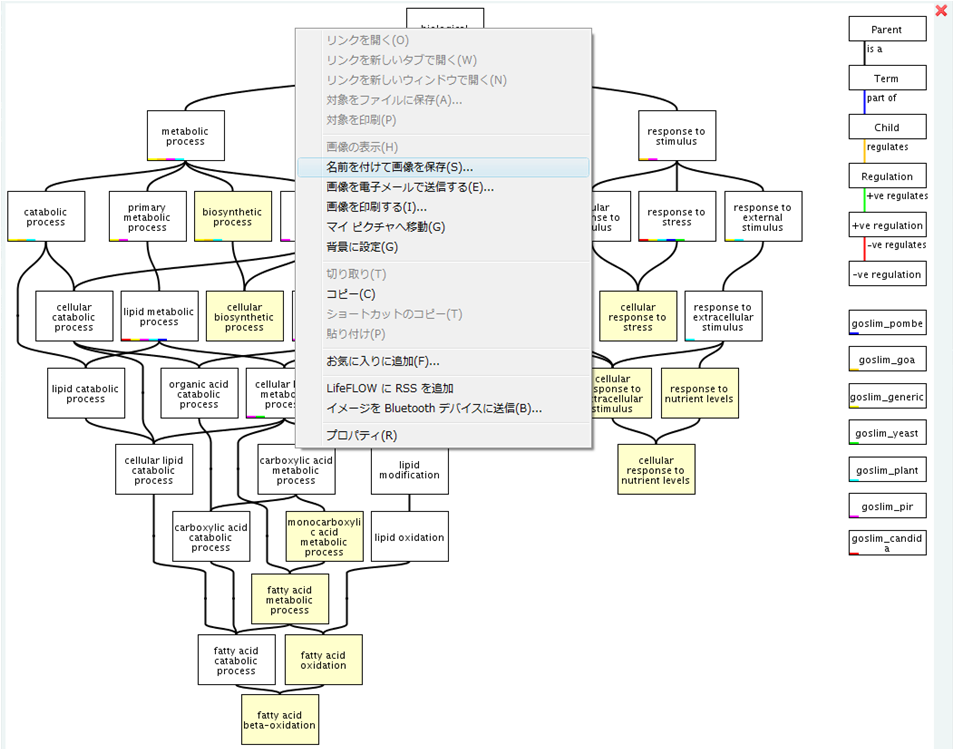

- 解析 | 機能解析 | PAGE法(Kim_2005)を用いてGene Ontology解析した結果をQuickGOにかける (last modified 2009/9/15)

- 解析 | 機能解析 | PAGE法(Kim_2005;統計量の変換なし)を用いてPathway解析 (last modified 2009/11/19)

- 解析 | 機能解析 | PAGE法(Kim_2005;統計量の変換あり)を用いてPathway解析 (last modified 2009/10/27)

- 解析 | 機能解析 | PAGE法(Kim_2005)を用いてPathway解析した後 (last modified 2009/10/27)

- 解析 | 機能解析 | PAGE(Z-score)法(Kim_2005;統計量の変換なし)を用いてGene Ontology解析 (last modified 2011/10/27)

- 解析 | 機能解析 | Parametric Gene Set Enrichment Analysis (PGSEA) (Kim_2005) (last modified 2009/6/1)

- 解析 | 分類 | k-Nearest Neighbor (k-NN)(last modified 2007/04/25)

- 解析 | 分類 | Self-Organizing Maps (SOM)

- 解析 | 分類 | Support Vector Machine (SVM) (last modified 2007/04/18)

- 解析 | 分類 | Naive Bayesian (NB)

- 解析 | アレイCGH(DNAコピー数)解析 | について(last modified 2014/07/24)

- 解析 | アレイCGH(DNAコピー数)解析 | ADaCGH (Diaz-Uriarte_2007) (last modified 2009/12/08)

- 解析 | アレイCGH(DNAコピー数)解析 | GLAD (Hupe_2004) (last modified 2009/12/08)

- 解析 | アレイCGH(DNAコピー数)解析 | DNAcopy (Olshen_2004) (last modified 2009/12/8)

- 作図 | M-A plot (last modified 2013/07/04)

- 作図 | ヒートマップ | 1. 感覚をつかむ (last modified 2015/10/17)

- 作図 | ヒートマップ | 2. 色を自在に変える(col) (last modified 2015/10/17)

- 作図 | ヒートマップ | 3. データを変換してから表示(scale) (last modified 2015/10/16)

- 作図 | ヒートマップ | 4. 余白を変える(margins) (last modified 2015/11/10)

- 作図 | ヒートマップ | 5. 大きさを変える(cex) (last modified 2015/10/16)

- 作図 | ROC曲線(ROC curve) (last modified 2013/11/14)

- Links(last modified 2012/04/25)

はじめに

このページは、マイクロアレイ(microarray)データ取得後のデータ解析をRで行うための一連の手続きをまとめたものであり、特にアグリバイオインフォマティクス教育研究プログラムの被養成者向けに作成したものです。

Maintainerは門田幸二(東京大学大学院農学生命科学研究科)が永らく一人でやっていましたが、 2013年7月のリニューアル以降は私の出身研究室(東京大学・大学院農学生命科学研究科・応用生命工学専攻・生物情報工学研究室: 清水謙多郎教授)大学院生の孫建強氏が W3C validation、美しいコーディング、TCCパッケージ開発および有用関数のTCCへの追加など重要な役割を担っています。

また、私がこの仕事にこれだけの時間を費やせるのは、ボスである清水謙多郎教授の全面的なサポートのおかげです。

実験研究者の方々は、Rを使うとよさそうだということはわかってはいても敷居が高いためなかなか踏み込めないという人が多いことと思います。そこで、教育に携わる身として、これまでRにパッケージを提供してこられた諸氏の有用なプログラムとその使用例をこのページであらためて紹介することを通じて、実験研究者自身がよりよいマイクロアレイデータ解析を自力で行えるための一助になればと思っています。コピペで結果が出せます!

以下は、原著論文やRパッケージのvignetteなどから得た情報をまとめたものです。本当に正しいやり方かどうかなど一切の保証はできませんので予めご承知おきください。このページの中身自体は、所属機関とは一切関係ない一個人の備忘録のようなものです。が、所属機関の私の担当する大学院講義や講習会などで利用しています。

間違いや修正点、また「このような解析をやりたいがどうすればいいか?」などのリクエストがあればメール( )をいただければ幸いです。特にアグリバイオインフォマティクス教育研究プログラム被養成者からのリクエストは優先的に対応します。

)をいただければ幸いです。特にアグリバイオインフォマティクス教育研究プログラム被養成者からのリクエストは優先的に対応します。

ここで紹介した様々な方法のほかにも多数の紹介しきれていないものがあります。それらはBioconductorのAll Packagesから辿れます(2013/07/19現在、Bioconductor version 2.12で672個のパッケージがあります)。これらの開発や普及に携わっている諸氏に御礼申し上げます。

このページ内で用いる色についての説明:

コメント 特にやらなくてもいいコマンド プログラム実行時に目的に応じて変更すべき箇所 実行結果を表示(アンダーラインがついてるほうはリンクです。)

過去のお知らせ

- 2022年

- 「実験医学別冊 論文図表を読む作法」が出版されています。タイトル通りですが、私個人としてはAccumulation curveの解説を入れていただいて大変助かっております。これまでなかなかとっつきにくかった図の理解が進む良書だと思います。(2022/07/27)

- 「正規化 | Affymetrix GeneChip | DFW(Chen_2007)」を更新しました。しばらく使えなかったのですが、使えるやり方を掲載しました(中井雄治 氏提供情報)。正確にはとっくに情報提供いただいていたのですが、多忙のためずっと気にはなっていたものの反映できずにおりましたm(_ _)m(2022/04/17)

- 東京大学・大学院農学生命科学研究科・応用生命工学専攻の令和5(2023)年度大学院学生募集公開ガイダンスは、2022年5月7日(土)と5月28日(土)に開催します。(2022/04/17)

- 2021年

- 独習 Pythonバイオ情報解析が2021年3月に出版されています。一般的なプログラミング言語として解説から、塩基配列データの取り扱い、データの可視化、そしてRNA-seq解析周辺など、非常に豊富な内容となっています。編集代表の黒川顕先生にはNGSハンズオン講習会の最終年度でお世話になり、執筆者の多くの先生にはアグリバイオインフォマティクス教育研究プログラム関連講義でもお世話になっております。(2021/03/27)

- Dr.Bonoの生命科学データ解析 第2版が2021年3月に出版されています(バイオインフォマティクス初学者向けの本)。前回の第1版から3年以上経過しており、WindowsでのLinux環境(WSL2)の話など最新情報にアップデートされているのが基本形です。しかし、大枠として変わってない部分もさらっとでも読むとよいと思います。第1版当時の自分には無縁で記憶に残っていない事柄でも、今の自分と関係があるかもしれないからです(私の場合はそれがオーソログクラスターでした)。(2021/03/18)

- 令和3年度のアグリバイオインフォマティクス教育研究プログラムに関する情報をトップページに掲載しています。(2021/03/18)

- single-cell RNA-seq (scRNA-seq)の解析パイプラインのガイドラインに関する論文であるVieth et al., Nat Commun., 2019についての批評論文が公開されました (Kadota and Shimizu, Front Genet., 2020)。特にscRNA-seqをbulk RNA-seqと差別化する際の論法や、 比較対象として用いたbulk RNA-seq用の正規化法の選定に関して、論文調査不足・事実誤認・ミスリード・不誠実さといった観点で痛烈に批判しています。(2020/07/28)

- 諸般(主にコロナに対する東大の全体方針)の事情により、2020年のアグリバイオインフォマティクス教育研究プログラムは、 東京大学の学生に限定することとなりました(2020年3月17日決定)。既に応募いただいた方、そしてこれから応募しようと思っていた方々には残念なお知らせとなってしまいましたが、 ご理解いただけますと幸いですm(_ _)m (2020/03/17)

- 「正規化 | Affymetrix GeneChip | FARMS(Hochreiter_2006)」において、関数名をq.farmsからqFarmsに、そしてl.farmsからlFarmsに変更しました。(中井雄治 氏提供情報)。(2019/12/28)

- 「生命科学者のためのDr.Bonoデータ解析実践道場(著:坊農秀雅)」が出版されています。 今回の"Bono本"は、アグリバイオの大学院講義で丁寧に教えることが現実的に難しいLinux環境でのデータ解析の情報が丁寧に解説されています(アグリバイオの内容と相補的な関係)。 「聞いたことはあるがよく知らない事柄」が簡潔かつ丁寧に書かれているので、私は主にそのあたりの頭の整理に利用させてもらっています。(2019/09/30)

- 「進化で読み解く バイオインフォマティクス入門(著:長田直樹)」が出版されています。 本書の何よりも素晴らしいところは、単著だという点だと思います(統一感って重要)。そしてチャラチャラしたところがなく、中身がしっかりしており、 そして幅広い内容が丁寧に解説されているという点が非常によいと思います。(2019/07/05)

- 「正規化 | Affymetrix GeneChip | rmx(Kohl_2010)」(の例題2)を実行する際に、R 3.6.0とR 3.5.1でエラーが出ることを確認しました。 回避策としては、「正規化 | Affymetrix GeneChip | RMA(Irizarry_2003)」をご利用ください(坂井星辰 氏提供情報)。(2019/06/18)

- 「解析 | 発現変動 | 2群間 | 対応なし | Rank products (Breitling_2004)」でエラーが出るというお知らせをいただきました(橋詰 力 氏 提供情報)。 調査の結果、RankProd 2.0 (Del Carratore et al., 2017)にバージョンが上がっていることが判明しました。 新設した「解析 | 発現変動 | 2群間 | 対応なし | RankProd 2.0 (Del Carratore_2017)」のほうをご利用下さい。少なくともエラーは出ずに、妥当な結果であるところまでは確認しました。(2019/03/17)

- 2018年11月に「よくわかるバイオインフォマティクス入門(藤博幸 編)」という本が出ました。(2018/11/21)

- 「解析 | 機能解析 | 遺伝子オントロジー(GO)解析 | について」を更新しました。(2018/06/22)

- 「解析 | 機能解析 | パスウェイ(Pathway)解析 | について」を更新しました。(2018/06/22)

- 「前処理 | ID変換 | probe ID --> gene symbol」の例題2以降のコードを改良しました。 具体的には、例えば例題2において、「2つの入力ファイルの1列目のprobe ID情報の対応がとれる(同じ行の位置でなくてもよい)ことが前提です」 のように書いていましたが、実際には同じ行の位置でなければいけなかったことが判明したので、例題2以降のコードについてバグの修正を行いました(川路啓太氏 提供情報)。(2017/09/22)

- お知らせは主に(Rで)塩基配列解析で行っておりますのでそちらをご覧ください。 マイクロアレイ関連の講義や講演資料なども(Rで)塩基配列解析中の参考資料(講義、講習会、本など)から辿れます。(2014/05/15)

- 平成29年度NGSハンズオン講習会の ウェブページが公開されました。受講申込の受付期間は2017年5月15日(月)14時00分~6月23日(金)12時00分です。(2017/05/15)

- 「解析 | 機能解析 | パスウェイ(Pathway)解析 | GSAR (Rahmatallah_2017)」を追加しました。 比較するグループ間で発現の異なる遺伝子セットを検出するだけでなく、ネットワーク図やグループごとの最有力遺伝子(most influential genes or hub genes)も示してくれます。(2017/03/12)

- 「解析 | 発現変動 | 2群間 | 対応なし | Rank products (Breitling_2004)」 の例題3の下のほうで書いていた「log(G2/G1)列:log比(G2の算術平均 - G1の算術平均)値」に関する注釈を追加しました。(2016/08/30)

- 私の所属するアグリバイオインフォマティクス教育研究プログラムでは、平成29年度もバイオインフォ関連講義を行います。 例年東大以外の企業の方、研究員、大学院生が2-3割程度受講しております。受講ガイダンスは4月5日17:15- 於東大農です。 例年アグリバイオ所有ノートPCは台数が絶対的に足りないので、特に外部の受講希望者はできるだけ基本的に3時間以上バッテリーがもつノートPCを用意して臨んで下さい。(2017/02/20)

- 門田幸二 著シリーズ Useful R 第7巻 トランスクリプトーム解析刊行(共立出版)。 マイクロアレイ解析に関する最近の知見や、ROKU法 (Kadota et al., 2006)、WAD法 (Kadota et al., 2008)などについての解説も含んでいます。 書籍中のマイクロアレイ解析部分のRコードについては、このページの「書籍 | トランスクリプトーム解析 | ...」に掲載してあります。(2014/04/27)

- (かなり先の話ですが...)平成26年3月7日に東京お台場にて、HPCIチュートリアルの一部としてRでゲノム・トランスクリプトーム解析を行います。情報はかなりアップデート予定です、、、が既に満席なようですいません。。。(2013/11/25)

- 「(Rで)塩基配列解析」もリニューアルしました。(2013/07/30)

- どのブラウザからでもエラーなく見られる(W3C validation)ようにリニューアルしました。(2013/07/19)

- 2013年7月18日まで公開していた以前の「(Rで)マイクロアレイデータ解析」のウェブページや関連ファイルはRdemicroarray.zipからダウンロード可能です(88MB程度)。(2013/07/19)

- 私の所属するアグリバイオインフォマティクス教育研究プログラムでは、平成25年度も(東大生に限らず)バイオインフォ関連講義を行います。受講希望者は平成25年4月5日17:15-18:00に東大農学部二号館二階化学第一講義室にて開催予定の受講ガイダンスに出席してください。 例年東大以外の企業の方、研究員、学生が二割程度は受講しております。 このウェブページ関連講義は「オーム情報解析」、それ以外の私の担当講義は「ゲノム情報解析基礎」と「農学生命情報科学特論I」です。興味ある科目のみの受講も可能ですので、お気軽にどうぞ。(2013/03/19)

- アグリバイオインフォマティクス教育研究プログラムでは特任研究員の募集をしています(締切3/15)。(2013/02/18)

- 遺伝子セット解析の一つであるGSA (Efron_2007)が一通りできるようになりました(2012/06/08)

インストール | について

本ウェブページの2015年3月下旬までの推奨インストール手順Rのインストールと起動は、 20GB程度のHDD容量(2015年3月調べ)を必要とすること、そしてそれに伴いインストールにかかる時間、インストールするパッケージ数の増大に伴うエラー遭遇率の上昇のため、 東大有線LANでもストレスを感じるようになってきました。そのため、 ユーザごとのネットワーク環境にも配慮した様々な選択肢を2015年3月末に提供し、推奨手順を変更しました(正確には2011年ごろの推奨手順に戻しました)。 私の環境は、Windows PCは(Windows 7; 64 bit)、Macintosh PCはMacBook Pro (OS X Yosemite ver. 10.10; 64 bit)です。 「自分の環境は32 bitなんだけど、何ができて何ができないか教えて」的な質問には答えられません。 R Studioというものもありますが、私は普段使いません。 「インストール | Rパッケージ | 」で必要最小限のパッケージインストールにとどめるようにすれば R Studioでもいいかもしれませんが、自己責任でご自由にお使いください。 以下は、「R本体の最新版」と「必要最小限プラスアルファ(数GB?!)」の推奨インストール手順をまとめたものです。

- Windows版(R_install_win.pdf; 2015.04.01版)

- Macintosh版(R_install_mac.pdf; 2015.04.02版)

インストール | R本体 | 最新版 | Win用

最新版(リリース版のこと)は、下記手順を実行します。インストールが無事完了したら、 デスクトップに「R i386 3.X.Y (32 bitの場合; XやYの数値はバージョンによって異なります)」 または「R x64 3.X.Y (64 bitの場合)」アイコンが作成されます。 私は「R i386 3.X.Y」のアイコンは使わないので、いつもゴミ箱に捨てています。 「R x64 3.X.Y」アイコンのほうのみ利用しています。 尚、エンドユーザには実質的に無縁のものだと思いますが開発版(devel版)というのもあります。

- Rのインストーラを「実行」

- 聞かれるがままに「次へ」などを押してとにかくインストールを完了させる

- 「コントロールパネル」−「デスクトップのカスタマイズ」−「フォルダオプション」−「表示(タブ)」−「詳細設定」のところで、 「登録されている拡張子は表示しない」のチェックを外してください。

インストール | R本体 | 最新版 | Mac用

最新版(リリース版のこと)は、下記手順を実行します。インストールが無事完了したら、 Finderを起動して、左のメニューの「アプリケーション」をクリックすると、Rのアイコンが作成されていることが確認できます。 Win同様、エンドユーザには実質的に無縁のものだと思いますがMacにも開発版(devel版)というのがあります。

- http://cran.r-project.org/bin/macosx/の「R-3.X.Y-marvericks.pkg」をクリック。 (XやY中の数値はバージョンによって異なります)

- ダウンロードしたファイルをダブルクリックして、聞かれるがままに「次へ」などを押してとにかくインストールを完了させる

- 「Finder」-「環境設定」-「詳細」タブのところで「すべてのファイル名拡張子を表示」にチェックを入れる。

インストール | R本体 | 過去版 | Win用

昔のバージョンをインストールしたい局面もごく稀にあると思います。 その場合は、ここをクリックして、 任意のバージョンのものをインストールしてください。例えば、2014年10月リリースのver. 3.1.2をインストールしたい場合は、 3.1.2をクリックして、 「Download R 3.1.2 for Windows」 をクリックすれば、後は最新版と同じです。

インストール | R本体 | 過去版 | Mac用

昔のバージョンをインストールしたい局面もごく稀にあると思います。 その場合は、ここをクリックして、 任意のバージョンのものをインストールしてください。例えば、2014年10月リリースのver. 3.1.2をインストールしたい場合は、 ページ下部の「R-3.1.2-marvericks.pkg」 をクリックすれば、後は最新版と同じです。

インストール | Rパッケージ | ほぼ全て(20GB以上?!)

Rパッケージの2大リポジトリであるCRANとBioconductor 中のほぼすべてのパッケージをインストールするやり方です。 パソコンのHDD容量に余裕があって、数千個ものパッケージ(20GB程度分)を数時間以上かけてダウンロードしてインストールできる環境にある方は、 R本体を起動し、以下を「R コンソール画面上」でコピー&ペースト。 どこからダウンロードするか?と聞かれるので、その場合は自分のいる場所から近いサイトを指定しましょう。

install.packages(available.packages()[,1], dependencies=TRUE)#CRAN中にある全てのパッケージをインストール source("http://www.bioconductor.org/biocLite.R")#おまじない biocLite(all_group()) #Bioconductor中にある全てのパッケージをインストール

インストール | Rパッケージ | 必要最小限プラスアルファ(数GB?!)

(Rで)塩基配列解析、 (Rで)マイクロアレイデータ解析中で利用するパッケージ、 プラスアルファのパッケージをインストールするやり方です。 Rパッケージの2大リポジトリであるCRANとBioconductor から提供されているパッケージ群のうち、一部のインストールに相当しますので、相当短時間でインストールが完了します。 SAFEではなくsafeパッケージの間違いでした。2015.04.24に修正済みです。ご指摘ありがとうございましたm(_ _)m limmaの取得先が間違ってCRANになっているのを2015.05.25に修正しました。

1. R本体を起動

2. CRANから提供されているパッケージ群のインストール

以下を「R コンソール画面上」でコピー&ペースト。 どこからダウンロードするか?と聞かれるので、その場合は自分のいる場所から近いサイトを指定しましょう。

#options(repos="http://cran.ism.ac.jp/")#利用するリポジトリを指定(統計数理研究所の場合) #(Rで)塩基配列解析で主に利用 install.packages("clValid") #Dunn's index計算用のパッケージ。2016.11.03追加 install.packages("openxlsx") #EXCELファイル(.xlsx)を直接読み込むためのパッケージ。2015.11.12追加 install.packages("PoissonSeq") install.packages("rbamtools") #BAM形式ファイルを直接読み込むためのパッケージ。2016.09.14追加 install.packages("samr") #(Rで)塩基配列解析でも利用 install.packages("seqinr") #(Rで)塩基配列解析でも利用 #(Rで)マイクロアレイデータ解析で利用 install.packages("cclust") install.packages("class") install.packages("e1071") install.packages("GeneCycle") install.packages("gptk") install.packages("GSA") install.packages("mixOmics") install.packages("pvclust") install.packages("RobLoxBioC") #2016.05.10追加 install.packages("som") install.packages("st") install.packages("varSelRF") #アグリバイオの他の講義科目で利用予定 install.packages("ape") install.packages("cluster") install.packages("fields") install.packages("KernSmooth") install.packages("mapdata") install.packages("maps") install.packages("MASS") install.packages("MVA") install.packages("RCurl") #2015.07.24追加 install.packages("rgl") install.packages("scatterplot3d")

3. Bioconductorから提供されているパッケージ群のインストール

ゲノム配列パッケージ以外です。

source("http://bioconductor.org/biocLite.R")#おまじない

#(Rで)塩基配列解析で主に利用

biocLite("baySeq", suppressUpdates=TRUE)

biocLite("biomaRt", suppressUpdates=TRUE)#(Rで)塩基配列解析でも利用

biocLite("Biostrings", suppressUpdates=TRUE)#(Rで)塩基配列解析でも利用

#biocLite("BiSeq", suppressUpdates=TRUE)#2016.07.06にコメントアウト(cosmoとdoMCがなくなったようです)

biocLite("BSgenome", suppressUpdates=TRUE)

biocLite("bsseq", suppressUpdates=TRUE)

biocLite("ChIPpeakAnno", suppressUpdates=TRUE)

biocLite("chipseq", suppressUpdates=TRUE)

biocLite("ChIPseqR", suppressUpdates=TRUE)

biocLite("ChIPsim", suppressUpdates=TRUE)

biocLite("cosmo", suppressUpdates=TRUE)

biocLite("CSAR", suppressUpdates=TRUE)

biocLite("DECIPHER", suppressUpdates=TRUE)#2016.12.29追加

biocLite("DEGseq", suppressUpdates=TRUE)

biocLite("DESeq", suppressUpdates=TRUE)

biocLite("DESeq2", suppressUpdates=TRUE)

biocLite("DiffBind", suppressUpdates=TRUE)

biocLite("doMC", suppressUpdates=TRUE)

biocLite("EBSeq", suppressUpdates=TRUE)

biocLite("EDASeq", suppressUpdates=TRUE)

biocLite("edgeR", suppressUpdates=TRUE)

biocLite("GenomicAlignments", suppressUpdates=TRUE)

biocLite("GenomicFeatures", suppressUpdates=TRUE)

biocLite("ggplot2", suppressUpdates=TRUE)

biocLite("girafe", suppressUpdates=TRUE)

biocLite("Heatplus", suppressUpdates=TRUE)#2015.11.12追加

biocLite("impute", suppressUpdates=TRUE)

biocLite("limma", suppressUpdates=TRUE)#(Rで)塩基配列解析でも利用

biocLite("maSigPro", suppressUpdates=TRUE)#(Rで)塩基配列解析でも利用

biocLite("MBCluster.Seq", suppressUpdates=TRUE)

biocLite("msa", suppressUpdates=TRUE) #2015.12.18追加

biocLite("htSeqTools", suppressUpdates=TRUE)

biocLite("NBPSeq", suppressUpdates=TRUE)

biocLite("phyloseq", suppressUpdates=TRUE)

biocLite("PICS", suppressUpdates=TRUE)

biocLite("qrqc", suppressUpdates=TRUE)

biocLite("QuasR", suppressUpdates=TRUE)

biocLite("r3Cseq", suppressUpdates=TRUE)

biocLite("REDseq", suppressUpdates=TRUE)

biocLite("rGADEM", suppressUpdates=TRUE)

biocLite("rMAT", suppressUpdates=TRUE)

biocLite("Rsamtools", suppressUpdates=TRUE)

biocLite("rtracklayer", suppressUpdates=TRUE)

biocLite("segmentSeq", suppressUpdates=TRUE)

biocLite("SeqGSEA", suppressUpdates=TRUE)

biocLite("seqLogo", suppressUpdates=TRUE)

biocLite("ShortRead", suppressUpdates=TRUE)

biocLite("SplicingGraphs", suppressUpdates=TRUE)

biocLite("SRAdb", suppressUpdates=TRUE)

biocLite("TCC", suppressUpdates=TRUE) #(Rで)塩基配列解析でも利用

biocLite("TxDb.Celegans.UCSC.ce6.ensGene", suppressUpdates=TRUE)

biocLite("TxDb.Hsapiens.UCSC.hg19.knownGene", suppressUpdates=TRUE)

biocLite("TxDb.Hsapiens.UCSC.hg38.knownGene", suppressUpdates=TRUE)

biocLite("TxDb.Mmusculus.UCSC.mm10.knownGene", suppressUpdates=TRUE)

biocLite("TxDb.Rnorvegicus.UCSC.rn5.refGene", suppressUpdates=TRUE)

#biocLite("yeastRNASeq", suppressUpdates=TRUE)

#(Rで)マイクロアレイデータ解析で利用

biocLite("affy", suppressUpdates=TRUE)

biocLite("agilp", suppressUpdates=TRUE)

biocLite("annotate", suppressUpdates=TRUE)

biocLite("ArrayExpress", suppressUpdates=TRUE)

biocLite("beadarray", suppressUpdates=TRUE)

biocLite("BeadDataPackR", suppressUpdates=TRUE)

biocLite("betr", suppressUpdates=TRUE)

biocLite("BHC", suppressUpdates=TRUE)

biocLite("Category", suppressUpdates=TRUE)

biocLite("clusterStab", suppressUpdates=TRUE)

biocLite("DNAcopy", suppressUpdates=TRUE)

biocLite("frma", suppressUpdates=TRUE)

biocLite("gage", suppressUpdates=TRUE)

biocLite("gcrma", suppressUpdates=TRUE)

biocLite("genefilter", suppressUpdates=TRUE)

biocLite("GEOquery", suppressUpdates=TRUE)

biocLite("GLAD", suppressUpdates=TRUE)

biocLite("globaltest", suppressUpdates=TRUE)

biocLite("golubEsets", suppressUpdates=TRUE)

biocLite("GSAR", suppressUpdates=TRUE) #2017.01.27追加

biocLite("GSEABase", suppressUpdates=TRUE)

biocLite("GSVAdata", suppressUpdates=TRUE)#2017.03.07追加

biocLite("hgu133a.db", suppressUpdates=TRUE)

biocLite("hgu133plus2probe", suppressUpdates=TRUE)

biocLite("hgug4112a.db", suppressUpdates=TRUE)

biocLite("illuminaMousev2.db", suppressUpdates=TRUE)

biocLite("lumi", suppressUpdates=TRUE)

biocLite("marray", suppressUpdates=TRUE)

biocLite("inSilicoDb", suppressUpdates=TRUE)

biocLite("Mulcom", suppressUpdates=TRUE)

biocLite("multtest", suppressUpdates=TRUE)

biocLite("OCplus", suppressUpdates=TRUE)

biocLite("org.Hs.eg.db", suppressUpdates=TRUE)

biocLite("pathview", suppressUpdates=TRUE)#2016.07.06にPathviewをpathviewに変更

biocLite("pcot2", suppressUpdates=TRUE)

biocLite("pd.rat230.2", suppressUpdates=TRUE)#2017.02.24追加

biocLite("PGSEA", suppressUpdates=TRUE)

biocLite("plier", suppressUpdates=TRUE)

biocLite("puma", suppressUpdates=TRUE)

biocLite("RankProd", suppressUpdates=TRUE)

biocLite("rat2302.db", suppressUpdates=TRUE)

biocLite("rat2302probe", suppressUpdates=TRUE)

biocLite("safe", suppressUpdates=TRUE)

biocLite("SAGx", suppressUpdates=TRUE)

biocLite("sigPathway", suppressUpdates=TRUE)

biocLite("SpeCond", suppressUpdates=TRUE)

biocLite("SPIA", suppressUpdates=TRUE)

biocLite("topGO", suppressUpdates=TRUE)

biocLite("vsn", suppressUpdates=TRUE)

4. Bioconductorから提供されているパッケージ群のインストール

ゲノム配列パッケージです。一つ一つの容量が尋常でないため、 必要に応じてテキストエディタなどに予めコピペしておき、いらないゲノムパッケージを削除してからお使いください。

source("http://bioconductor.org/biocLite.R")#おまじない

biocLite("BSgenome.Athaliana.TAIR.TAIR9", suppressUpdates=TRUE)#シロイヌナズナゲノム

biocLite("BSgenome.Celegans.UCSC.ce6", suppressUpdates=TRUE)#線虫ゲノム

biocLite("BSgenome.Drerio.UCSC.danRer7", suppressUpdates=TRUE)#ゼブラフィッシュゲノム

biocLite("BSgenome.Hsapiens.NCBI.GRCh38", suppressUpdates=TRUE)#ヒトゲノム(GRCh38)

biocLite("BSgenome.Hsapiens.UCSC.hg19", suppressUpdates=TRUE)#ヒトゲノム(hg19)

biocLite("BSgenome.Mmusculus.UCSC.mm10", suppressUpdates=TRUE)#マウスゲノム(mm10)

インストール | Rパッケージ | 必要最小限(数GB?!)

(Rで)マイクロアレイデータ解析中で利用するパッケージのみインストールするやり方です。 Rパッケージの2大リポジトリであるCRANとBioconductor から提供されているパッケージ群のうち、ごく一部のインストールに相当しますので、相当短時間でインストールが完了します。 SAFEではなくsafeパッケージの間違いでした。2015.04.24に修正済みです。ご指摘ありがとうございましたm(_ _)m limmaの取得先が間違ってCRANになっているのを2015.05.25に修正しました。

1. R本体を起動

2. CRANから提供されているパッケージ群のインストール

以下を「R コンソール画面上」でコピー&ペースト。 どこからダウンロードするか?と聞かれるので、その場合は自分のいる場所から近いサイトを指定しましょう。

install.packages("cclust")

install.packages("class")

install.packages("e1071")

install.packages("GeneCycle")

install.packages("gptk")

install.packages("GSA")

install.packages("mixOmics")

install.packages("pvclust")

#install.packages("RobLoxBioC")

install.packages("samr")

install.packages("seqinr")

install.packages("som")

install.packages("st")

install.packages("varSelRF")

3. Bioconductorから提供されているパッケージ群のインストール

ゲノム配列パッケージ以外です。

source("http://bioconductor.org/biocLite.R")#おまじない

biocLite("affy", suppressUpdates=TRUE)

biocLite("agilp", suppressUpdates=TRUE)

biocLite("annotate", suppressUpdates=TRUE)

biocLite("ArrayExpress", suppressUpdates=TRUE)

biocLite("beadarray", suppressUpdates=TRUE)

biocLite("BeadDataPackR", suppressUpdates=TRUE)

biocLite("betr", suppressUpdates=TRUE)

biocLite("BHC", suppressUpdates=TRUE)

biocLite("biomaRt", suppressUpdates=TRUE)

biocLite("Biostrings", suppressUpdates=TRUE)

biocLite("Category", suppressUpdates=TRUE)

biocLite("clusterStab", suppressUpdates=TRUE)

biocLite("DNAcopy", suppressUpdates=TRUE)

biocLite("frma", suppressUpdates=TRUE)

biocLite("gage", suppressUpdates=TRUE)

biocLite("gcrma", suppressUpdates=TRUE)

biocLite("genefilter", suppressUpdates=TRUE)

biocLite("GEOquery", suppressUpdates=TRUE)

biocLite("GLAD", suppressUpdates=TRUE)

biocLite("globaltest", suppressUpdates=TRUE)

biocLite("golubEsets", suppressUpdates=TRUE)

biocLite("GSEABase", suppressUpdates=TRUE)

biocLite("hgu133a.db", suppressUpdates=TRUE)

biocLite("hgu133plus2probe", suppressUpdates=TRUE)

biocLite("hgug4112a.db", suppressUpdates=TRUE)

biocLite("illuminaMousev2.db", suppressUpdates=TRUE)

biocLite("limma", suppressUpdates=TRUE)

biocLite("lumi", suppressUpdates=TRUE)

biocLite("marray", suppressUpdates=TRUE)

biocLite("maSigPro", suppressUpdates=TRUE)

biocLite("inSilicoDb", suppressUpdates=TRUE)

biocLite("Mulcom", suppressUpdates=TRUE)

biocLite("multtest", suppressUpdates=TRUE)

biocLite("OCplus", suppressUpdates=TRUE)

biocLite("org.Hs.eg.db", suppressUpdates=TRUE)

biocLite("Pathview", suppressUpdates=TRUE)

biocLite("pcot2", suppressUpdates=TRUE)

biocLite("PGSEA", suppressUpdates=TRUE)

biocLite("plier", suppressUpdates=TRUE)

biocLite("puma", suppressUpdates=TRUE)

biocLite("RankProd", suppressUpdates=TRUE)

biocLite("rat2302.db", suppressUpdates=TRUE)

biocLite("rat2302probe", suppressUpdates=TRUE)

biocLite("safe", suppressUpdates=TRUE)

biocLite("SAGx", suppressUpdates=TRUE)

biocLite("sigPathway", suppressUpdates=TRUE)

biocLite("SpeCond", suppressUpdates=TRUE)

biocLite("SPIA", suppressUpdates=TRUE)

biocLite("TCC", suppressUpdates=TRUE)

biocLite("topGO", suppressUpdates=TRUE)

biocLite("vsn", suppressUpdates=TRUE)

インストール | Rパッケージ | 個別

多くのBSgenome系パッケージや TxDb系のパッケージは、「ほぼ全て」の手順ではインストールされません。 理由は、BSgenomeはゲノム配列情報のパッケージなので、ヒトゲノムの様々なバージョン、マウスゲノム、ラットゲノムなどを全部入れると大変なことになるからです。 それでもピンポイントで必要に迫られる局面もあると思いますので、ここではRのパッケージを個別にインストールするやり方を示します。

1. ゼブラフィッシュゲノムのパッケージ(BSgenome.Drerio.UCSC.danRer7)をインストールしたい場合:

400MB程度あります...。

param <- "BSgenome.Drerio.UCSC.danRer7"#パッケージ名を指定 #本番 source("http://bioconductor.org/biocLite.R")#おまじない biocLite(param, suppressUpdates=TRUE) #おまじない

2. TxDb.Rnorvegicus.UCSC.rn5.refGeneパッケージのインストールをしたい場合:

param <- "TxDb.Rnorvegicus.UCSC.rn5.refGene"#パッケージ名を指定 #本番 source("http://bioconductor.org/biocLite.R")#おまじない biocLite(param, suppressUpdates=TRUE) #おまじない

3. TxDb.Hsapiens.UCSC.hg38.knownGeneパッケージのインストールをしたい場合:

param <- "TxDb.Hsapiens.UCSC.hg38.knownGene"#パッケージ名を指定 #本番 source("http://bioconductor.org/biocLite.R")#おまじない biocLite(param, suppressUpdates=TRUE) #おまじない

4. 線虫ゲノムのパッケージ(BSgenome.Celegans.UCSC.ce6)をインストールしたい場合:

20MB程度です。

param <- "BSgenome.Celegans.UCSC.ce6" #パッケージ名を指定 #本番 source("http://bioconductor.org/biocLite.R")#おまじない biocLite(param, suppressUpdates=TRUE) #おまじない

5. TxDb.Celegans.UCSC.ce6.ensGeneパッケージのインストールをしたい場合:

param <- "TxDb.Celegans.UCSC.ce6.ensGene"#パッケージ名を指定 #本番 source("http://bioconductor.org/biocLite.R")#おまじない biocLite(param, suppressUpdates=TRUE) #おまじない

6. Heatplusパッケージのインストールをしたい場合:

param <- "Heatplus" #パッケージ名を指定 #本番 source("http://bioconductor.org/biocLite.R")#おまじない biocLite(param, suppressUpdates=TRUE) #おまじない

(削除予定)Rのインストールと起動

よく分からない人でWindowsユーザーの方は以下を参考にしてください。2014年4月22日に作成したWindows用のインストール手順はこちら。 2014年5月14日にアップデートしたMac版のインストール手順こちら(by 孫建強氏)もあります。 注意点は、「Mac OS X のバージョンに関わらず R-3.1.0-snowleopard.pkg をインストールしたほうがよい」です。

1. Windows release版のインストールの場合:

- Rのインストーラを「実行」

- 聞かれるがままに「次へ」などを押してとにかくインストールを完了させる

- Windows Vistaの人は(パッケージのインストール中に書き込み権限に関するエラーが出るのを避けるために)「コントロールパネル」−「ユーザーアカウント」−「ユーザーアカウント制御の有効化または無効化」で、「ユーザーアカウント制御(UAC)を使ってコンピュータの保護に役立たせる」のチェックをあらかじめ外しておくことを強くお勧めします。

- インストールが無事完了したら、デスクトップに出現する「R3.X.Y (32 bitの場合; XやY中の数値はバージョンによって異なります)」または「R x64 3.X.Y (64 bitの場合)」アイコンをダブルクリックして起動

- 以下を、「R コンソール画面上」でコピー&ペーストする。10GB程度のディスク容量を要しますが一番お手軽です。(どこからダウンロードするか?と聞かれるので、その場合は自分のいる場所から近いサイトを指定)

source("http://www.iu.a.u-tokyo.ac.jp/~kadota/R/mvo.R")#おまじない install.packages(available.packages()[,1], dependencies=TRUE)#CRAN中にある全てのパッケージをインストール source("http://www.bioconductor.org/biocLite.R")#おまじない biocLite(all_group()) #Bioconductor中にある全てのパッケージをインストール - 「コントロールパネル」−「フォルダオプション」−「表示(タブ)」−「詳細設定」のところで、「登録されている拡張子は表示しない」のチェックを外してください。

2. Windows devel版(R-devel)のインストールの場合(advanced userのみ):

- Rのインストーラを「実行」

- 聞かれるがままに「次へ」などを押してとにかくインストールを完了させる

- R-develを起動し、以下を、「R コンソール画面上」でコピー&ペーストする。

for (i in available.packages()[,1]){#CRAN中にある全てのパッケージをインストール try(install.packages(i, dependencies=TRUE))#CRAN中にある全てのパッケージをインストール } #CRAN中にある全てのパッケージをインストール source("http://www.bioconductor.org/biocLite.R")#おまじない biocLite(all_group()) #Bioconductor中にある全てのパッケージをインストール

(削除予定)Rの昔のバージョンのインストール

DFW (Chen et al., Bioinformatics, 2007)というAffymetrixチップの正規化法でわりとよく "思い通りの"階層的クラスタリング結果を導くような遺伝子発現行列データを生成してくれるAffymetrixデータ用の正規化法(嫌味ではなくいい方法なんだと思います)があります。 しかしこの正規化法は、R2.7.2あたりだと正常に動作していましたが、比較的最近のバージョン(R2.8.1以降)ではうまく動いてくれません。 そのような場合でも、Rの昔のバージョンをインストールしてDFWを実行することによって、DFWを利用することができます。 このような目的のために、ここでは、Rの任意の昔のバージョンをインストールするやり方をR2.7.2のインストールを例に紹介します

- ここをクリックして、任意のRのバージョンのところをクリック(例えば2.7.2)

- R-X.Y.Z-win32.exe(例えばR-2.7.2-win32.exe)をクリックして「実行」ボタンなどを聞かれるがままに押す

- R-X.Y.Zのアイコンがデスクトップにできるので、立ち上げて以下をコピペ

source("http://bioconductor.org/biocLite.R")#おまじない biocLite("affy") #おまじない

これであとはDFWを参考にしてDFWの結果をエンジョイしてください。

使用例(初心者向け):

Step 1:

Rを起動して以下をコピー&ペーストしてみてください。自分のマイクロアレイデータ解析を実際にRを用いて行う上で、このページの情報をもとに自分がどのような作業をすれば目的を達成できるかの参考になるはずです。

1+2 #1+2を計算 hoge <- 4 #hogeに4を代入 hoge #hogeの中身を表示 sqrt(hoge) #4のルートを計算 sqrt(4) #4のルートを計算(当然同じ意味) #の後の文章はコメントなので何を書いてもいいですよ。

Step 2:

実際に自分のマイクロアレイデータを用いて解析をしようと思い始めたとき、数行を一度にコピー&ペーストすると、様々なパラメータを変更することができずにつまづくことがあるかもしれません。そのような場合、例えば「ワードパッド」や「メモ帳」で予め作成しておいた一連のコマンド群からなるrun.txtを用意しておき、その中身をコピー&ペーストすることでrun.txtの中身を実行します。

Step 3:

コマンドライン上に表示される R の出力をファイルにそのまま保存したいと思う場面が出てきます。このような場合、

- まず出力される先のディレクトリを、「ファイル」−「ディレクトリの変更」で指定

- 以下をコピー&ペースト

sink("out.txt") #出力ファイル名をout.txtとする 1+2 #1+2を計算 hoge <- 4 #hogeに4を代入 hoge #hogeの中身を表示 sqrt(hoge) #4のルートを計算 sqrt(4) #4のルートを計算(当然同じ意味) #の後の文章はコメントなので何を書いてもいいですよ。コマンドライン上に結果が表示されず、out.txtに結果が以下のように表示されていることと思います:

| out.txtの中身 |

[1] 3 [1] 4 [1] 2 [1] 2

尚、sink()と入力すれば、out.txtに出力させるのをやめさせることができます。

- library():どのようなパッケージがインストールされているかを知る

- library(help="パッケージ名"):「パッケージ名」で指定したパッケージ中にどのような関数があるかを知る

- update.packages():手持ちのパッケージをアップデート

- getBioC("パッケージ名"):「パッケージ名」で指定したパッケージをインストール

- sample(x, n, replace=F):ベクトルxから長さnの部分ベクトルをランダムにサンプリング

- objects():今現在利用可能なオブジェクのリストを表示

- unique():重複を除去

- duplicated():重複があるものをTRUEとして表示

- rle():例えば「x <- c("C", "A", "B", "C", "C", "D"); rle(sort(x))」とやると、Aが1, Bが1, Cが3, Dが1といった情報を返してくれる

- table():例えばある離散データ「x <- rpois(50, lambda = 4)」を生成させて、「table(factor(x, 0:max(x)))」とやると、どの数値のものがいくつあったかを返してくれる

サンプルデータ

-

3051 genes×38 samplesからなる二群の遺伝子発現データ。最初の27サンプルがG1群、残りの11サンプルがG2群のデータです。

sample1.txt (遺伝子発現データ)

sample1_cl.txt (クラスラベルデータ)

以下を実行して得られるデータと本質的に同じものです。

library(multtest) data(golub) dim(golub) -

6 genes×11 samplesからなる二群の遺伝子発現データ。最初の6サンプルがG1群、残りの5サンプルがG2群のデータです。

sample2.txt (遺伝子発現データ)

sample2_cl.txt (クラスラベルデータ)

-

45 genes×10 samplesからなる遺伝子発現データ。sample3.txt

このデータは以下のコマンドを実行したのち、sample3_tmp.txtのラベル情報部分を微修正して得ました。

sample3_tmp <- rbind(matrix(rnorm(150, mean=0, sd=0.2), ncol=10), matrix(rnorm(150, mean=1, sd=0.2), ncol=10), matrix(rnorm(150, mean=2, sd=0.2), ncol=10)) write.table(sample3_tmp, "sample3_tmp.txt", sep = "\t", append=F, quote=F, col.names=F) -

Ge et al., Genomics, 2005 (GSE2361)の22,283 genes×36 samplesからなる多群の遺伝子発現データ

GDS1096.txt

実際には

で読み込んでも「IDENTIFIER」カラムが余分にあります。そのため、読み込み後にGDS1096 <- read.table("GDS1096.txt", header=TRUE, row.names=1, sep="\t", quote="")

とやっておく必要があります。GDS1096$IDENTIFIER <- NULL

ちなみにこのデータはGDS1096からダウンロードして得られたGDS1096.soft.txtファイルを加工したものです。

MAS-quantified dataです(2007/7/3追加)。 -

Ge et al., Genomics, 2005 (GSE2361)の22,283 probesets×36 samplesからなる多群の遺伝子発現データ

RMA-preprocessed dataです。

sample5.txt -

10 genes×20 samplesからなる遺伝子発現データ。欠損値, NaN, NAなどを含むデータです。

sample6.txt -

Golub et al., Science, 1999の7,129 genesからなる二群の遺伝子発現データ

ALL(G1群; 47 samples)が1, AML(G2群; 25 samples)が2でラベルされています。

sample7.txt (遺伝子発現データ)

sample7_cl.txt (クラスラベルデータ)

out_f1 <- "sample7.txt" #出力ファイル名を指定してout_f1に格納 out_f2 <- "sample7_cl.txt" #出力ファイル名を指定してout_f2に格納 library(golubEsets) data(Golub_Merge) tmp_names <- paste(as.character(Golub_Merge$ALL.AML), colnames(exprs(Golub_Merge)), sep="_") data <- exprs(Golub_Merge) colnames(data) <- tmp_names tmp <- cbind(rownames(data), data) write.table(tmp, out_f1, sep = "\t", append=F, quote=F, row.names=F) data.cl <- as.numeric(Golub_Merge$ALL.AML) write.table(cbind(tmp_names, data.cl), out_f2, sep = "\t", append=F, quote=F, row.names=F, col.names=F)

-

Singh et al., Cancer Cell, 2002の12,600 genesからなる二群の遺伝子発現データ

最初の50サンプルがG1群(non-tumor prostate)、残りの52サンプルがG2群(prostate tumor)のデータです。

data_Singh_RMA.txt (RMA-quantified data; Jeffery et al., BMC Bioinformatics, 2006で公開されているSingh.txtを加工したもの)

data_Singh_MAS.txt (MAS-quantified data; 原著論文のweb supplementから利用可能なProstate_TN_final0701_allmeanScale.resを加工したもの)

「Prostate_TN_final0701_allmeanScale.res」中には12,600 clones分の情報しかないため、(ProbeSetIDが"1600***"という)余分な25 clones分のデータを除去している。

-

Singh et al., Cancer Cell, 2002の3,274 genesからなる二群の遺伝子発現データ

最初の50サンプルがG1群(non-tumor prostate)、残りの52サンプルがG2群(prostate tumor)のデータです。

data_Singh_RMA_3274.txt (RMA-quantified data)

data_Singh_MAS_3274.txt (MAS-quantified data)

計算を軽くするために、MASのデータで全102サンプル中半分(51サンプル)以上で"Present" callとなっていた3,274クローンからなるサブセットにしたものです。

- 1,000 genesからなる時系列の遺伝子発現データ maSigPro (Conesa et al., Bioinformatics, 2006) で提供されているサンプルデータです。

-

「通常状態(Control)のサンプルの薬剤処理後3時間(3 replicates), 9時間(2 replicates), そして27時間後(3 replicates)の遺伝子発現データ」、「低温状態(Cold)の...」、「高温状態(Heat)の...」からなる計1,000 ProbeSets×24 arraysからなる遺伝子発現データとその実験デザイン情報のデータ

sample10_3groups.txt (遺伝子発現データ)

sample10_3groups_cl.txt (実験デザイン情報データ) -

「通常状態(Control)のサンプルの薬剤処理後3時間(3 replicates), 9時間(2 replicates), そして27時間後(3 replicates)の遺伝子発現データ」、「低温状態(Cold)の...」からなる計1,000 ProbeSets×16 arraysからなる遺伝子発現データとその実験デザイン情報のデータ

sample10_2groups.txt (遺伝子発現データ)

sample10_2groups_cl.txt (実験デザイン情報データ) -

「ある(Control)のサンプルの薬剤処理後3時間(3 replicates), 9時間(2 replicates), そして27時間後(3 replicates)の遺伝子発現データ」からなる計1,000 ProbeSets×8 arraysからなる遺伝子発現データとその実験デザイン情報のデータ

sample10_1group.txt (遺伝子発現データ)

sample10_1group_cl.txt (実験デザイン情報データ) -

1,000 genesの時系列遺伝子発現データ

-

「サンプル1の薬剤処理後0.5, 2, 5, 12.3, 24時間後の遺伝子発現データ」と「サンプル2の薬剤処理後0.5, 2, 5, 12.3, 24時間後の遺伝子発現データ」からなる計1,000 ProbeSets×10 arraysからなる”対応あり”遺伝子発現データ

sample11_2groups_paired.txt (遺伝子発現データ)

sample11_2groups_paired_cl.txt (クラスラベルデータ) -

「サンプル1の薬剤処理後0.5, 2, 5, 12.3, 24時間後の遺伝子発現データ」と「サンプル2の薬剤処理後1.3, 4, 8, 12, 20時間後の遺伝子発現データ」からなる計1,000 ProbeSets×10 arraysからなる”対応なし”遺伝子発現データ

sample11_2groups_unpaired.txt (遺伝子発現データ)

sample11_2groups_unpaired_cl.txt (クラスラベルデータ) -

「サンプル1の薬剤処理後0.5, 2, 5, 12.3, 24時間後の遺伝子発現データ」からなる計1,000 ProbeSets×5 arraysからなる遺伝子発現データ

sample11_1group.txt (遺伝子発現データ)

sample11_1group_cl.txt (クラスラベルデータ)

-

「サンプル1の薬剤処理後0.5, 2, 5, 12.3, 24時間後の遺伝子発現データ」と「サンプル2の薬剤処理後0.5, 2, 5, 12.3, 24時間後の遺伝子発現データ」からなる計1,000 ProbeSets×10 arraysからなる”対応あり”遺伝子発現データ

-

Laub et al., Science, 2000の1,444 genes×11 time points (0, 15, 30, 45, 60, 75, 90, 105, 120, 135, 150min)からなる時系列遺伝子発現データ

sample12.txt

このデータは以下のコマンドを実行したのち、sample12_tmp.txtのラベル情報部分を微修正して得ました。

library(GeneCycle) data(caulobacter) data <- t(caulobacter) tmp <- cbind(rownames(data), data) write.table(tmp, "sample12_tmp.txt", sep = "\t", append=F, quote=F, row.names=F)

-

Hayashi et al., Psychother Psychosom, 2006 (GSE1322)の22,575 genesからなる二群の遺伝子発現データ(Agilent two-colorデータ)

-

最初の14サンプルがG1群(面白い話を聞いた患者)、残りの7サンプルがG2群(退屈な講義を聞いた患者)でlog2(聞いた後/聞く前)の値になっています。

sample13.txt -

sample13.txtのサブセットで、最初の7サンプルがG1群(面白い話を聞いた患者)、残りの7サンプルがG2群(退屈な講義を聞いた患者)でlog2(聞いた後/聞く前)の値になっています。原著論文ではこのサブセットで解析していたので念のため用意しました。

sample13_7vs7.txt

このデータはsample13.txtを入力として、以下のコマンドを実行することによって得ました。

in_f <- "sample13.txt" #入力ファイル名を指定してin_fに格納 out_f <- "sample13_7vs7.txt" #出力ファイル名を指定してout_fに格納 #データファイルの読み込み data <- read.table(in_f, header=TRUE, row.names=1, sep="\t", quote="")#in_fで指定したファイルの読み込み #本番 data.tmp <- data[,c(3:6,9,13:21)] #行列dataの中から3-6, 9, 13-21列のデータのみ抽出してdata.tmpに格納 #ファイルに保存 tmp <- cbind(rownames(data), data.tmp) #遺伝子名の右側にdata.tmpを追加して、tmpに格納。 write.table(tmp, out_f, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

最初の14サンプルがG1群(面白い話を聞いた患者)、残りの7サンプルがG2群(退屈な講義を聞いた患者)でlog2(聞いた後/聞く前)の値になっています。

-

22,283 genes×6 samplesからなる二群の遺伝子発現データ。最初の3サンプルがG1群、残りの3サンプルがG2群のデータです。

sample14.txt -

5 genes×8 samplesからなる多群の遺伝子発現データ。

以下のクラスラベルデータは"tissue4"特異的高発現遺伝子を検出したいときのものです。

sample15.txt (遺伝子発現データ)

sample15_cl.txt (クラスラベルデータ) -

3 genes×11 samplesからなる二群の遺伝子発現データ。

最初の6サンプルがG1群、残りの5サンプルがG2群のデータです。2014年5月23にサンプルラベル情報を「A1, A2, ..., B1, B2, ...」から 「G1_1, G1_2, ..., G2_1, G2_2, ...」に変更しました。

sample16.txt (遺伝子発現データ; 対数変換前)

sample16_cl.txt (クラスラベルデータ)

sample16_log.txt (遺伝子発現データ; 対数変換後)

対数変換後のデータは以下のコピペで作成しました。

in_f <- "sample16.txt" #入力ファイル名を指定してin_fに格納 out_f <- "sample16_log.txt" #出力ファイル名を指定してout_fに格納 #データファイルの読み込み data <- read.table(in_f, header=TRUE, row.names=1, sep="\t", quote="")#in_fで指定したファイルの読み込み #本番 summary(data) #シグナル強度の分布を確認し、ダイナミックレンジが4桁程度あることを確認 data[data < 1] <- 1 #シグナル強度が1未満のものを1にする data.log <- log(data, base=2) #log2-transformed dataをdata.logに格納 summary(data.log) #対数変換後のシグナル強度の分布を確認 #ファイルに保存 tmp <- cbind(rownames(data), data.log) #遺伝子名の右側にdata.logを追加して、tmpに格納。 write.table(tmp, out_f, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

14,026 genes×8 samplesからなる二群の遺伝子発現データ)。

最初の4サンプルがG1群、残りの4サンプルがG2群のデータです。

対数変換していないデータ:sample17_unlog.txt

対数変換しているデータ:sample17.txt

-

以下の図のようなデータ

sample18_5vs5.txt

-

10 genesからなる遺伝子発現データ。RMA法を適用したときにサンプル数の増減による影響を調べるためのデータです。

2 samplesからなるデータ:sample19.txt

3 samplesからなるデータ:sample19_plus1.txt

-

Nakai et al., BBB, 2008のGSE7623由来データ(RMA-preprocessed)

- data_GSE7623_rma.txt(31,099 probesets×24 samples)

- data_mas.txt(31,099 probesets×24 samples; ラベル情報部分をわかりやすくしたもの)

- data_rma_2.txt(31,099 probesets×24 samples; ラベル情報部分をわかりやすくしたもの)

- data_rma_2_BAT.txt(31,099 probesets×8 samples; BAT sampleのみでfed vs. 24h-fastedの2群間比較用)

- data_rma_2_LIV.txt(31,099 probesets×8 samples; LIV sampleのみでfed vs. 24h-fastedの2群間比較用)

- data_rma_2_WAT.txt(31,099 probesets×8 samples; WAT sampleのみでfed vs. 24h-fastedの2群間比較用)

GSM184414-184417: Brown adipose tissue (BAT), fed GSM184418-184421: Brown adipose tissue (BAT), 24 h-fasted GSM184422-184425: White adipose tissue (WAT), fed GSM184426-184429: White adipose tissue (WAT), 24 h-fasted GSM184430-184433: Liver tissue (LIV), fed GSM184434-184437: Liver tissue (LIV), 24 h-fasted

- data_rma_2_nr.txt(14,132 genes×24 samples; 同じgene symbolのものをまとめたもの)

- data_rma_2_nr_BAT.txt(14,132 genes×8 samples; BAT sampleのみでfed vs. 24h-fastedの2群間比較用)

- data_rma_2_nr_LIV.txt(14,132 genes×8 samples; LIV sampleのみでfed vs. 24h-fastedの2群間比較用)

ちなみに、これは「Affymetrix Rat Genome 230 2.0 Array」を用いて取得したデータでGPL1355からアノテーションファイルを取得可能です。 2群間比較手法の一つであるRank products (Breitling_2004)の2をテンプレートとしてFDR < 0.05を満たすprobesetIDを得た結果ファイルが以下のものたち:

- data_rma_2_BAT.txtを入力として得られた発現変動遺伝子IDリストファイル:result_rankprod_BAT_id.txt

- data_rma_2_LIV.txtを入力として得られた発現変動遺伝子IDリストファイル:result_rankprod_LIV_id.txt

- data_rma_2_WAT.txtを入力として得られた発現変動遺伝子IDリストファイル:result_rankprod_WAT_id.txt

(Rで)塩基配列解析のイントロ | 一般 | 任意のキーワードを含む行を抽出(基礎)の11をテンプレートとしてprobesetID --> RefSeq IDに変換したファイルが以下のものたち:

- result_rankprod_BAT_RefSeq_DEG.txt(774 RefSeq IDs)

- result_rankprod_BAT_RefSeq_nonDEG.txt(12,969 RefSeq IDs)

- result_rankprod_LIV_RefSeq_DEG.txt(559 RefSeq IDs)

- result_rankprod_LIV_RefSeq_nonDEG.txt(13,255 RefSeq IDs)

- result_rankprod_WAT_RefSeq_DEG.txt(601 RefSeq IDs)

- result_rankprod_WAT_RefSeq_nonDEG.txt(13,269 RefSeq IDs)

(Rで)塩基配列解析の前処理 | フィルタリング | 任意のIDを含む配列を抽出 などをテンプレートとしてリスト中のRefSeq IDに相当する(ACGTのみからなる配列で配列長が同じ)サブセットを抽出したmulti-fastaファイル群:

- seq_BAT_DEG.fa(563 RefSeq sequences)

- seq_BAT_nonDEG.fa(8,898 RefSeq sequences)

- seq_LIV_DEG.fa(426 RefSeq sequences)

- seq_LIV_nonDEG.fa(9,075 RefSeq sequences)

- seq_WAT_DEG.fa(453 RefSeq sequences)

- seq_WAT_nonDEG.fa(9,092 RefSeq sequences)

-

TCCパッケージ(Sun et al., BMC Bioinformatics, 2013)中の8 genes×10 tissuessからなる発現データ(sample21.txt)です。

ROKU論文(Kadota et al., BMC Bioinformatics, 2006)のFig.1で示した仮想データに似た数値にしてあります。以下のコピペで作成しました:

library(TCC) #パッケージの読み込み data(hypoData_ts) #データをロード #ファイルに保存 tmp <- cbind(rownames(hypoData_ts), hypoData_ts)#「rownames情報」と「発現データ」を列方向で結合した結果をtmpに格納 write.table(tmp, "sample21.txt", sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

10000 genes×6 samplesからなる二群の遺伝子発現データ。

最初の3サンプルがG1群、残りの3サンプルがG2群の標準正規分布に従う乱数からなるシミュレーションデータです。

乱数を発生させただけのデータなので、発現変動遺伝子(DEG)がない全てがnon-DEGのデータです。

以下のコピペで作成しました:

out_f <- "sample22.txt" #出力ファイル名を指定してout_fに格納 param_G1 <- 3 #G1群のサンプル数を指定 param_G2 <- 3 #G2群のサンプル数を指定 param_Ngene <- 10000 #全遺伝子数を指定 #ランダムデータの生成 set.seed(1000) #おまじない(同じ乱数になるようにするため) hoge <- rnorm(param_Ngene*(param_G1+param_G2))#param_Ngene*(param_G1+param_G2)個分の乱数を発生させた結果をhogeに格納 data <- matrix(hoge, nrow=param_Ngene) #param_Ngene*(param_G1+param_G2)個分の要素からなるベクトルhogeを変換して(param_Ngene)個の行数からなる行列を作成した結果をdataに格納 rownames(data) <- paste("gene", 1:param_Ngene, sep="_")#行名を付与 colnames(data) <- c(paste("G1_rep",1:param_G1,sep=""),paste("G2_rep",1:param_G2,sep=""))#列名を付与 #ファイルに保存 tmp <- cbind(rownames(data), data) #「rownames情報」と「発現データ」を列方向で結合した結果をtmpに格納 write.table(tmp, out_f, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

10,000 genes×6 samplesからなる二群の遺伝子発現データ。

最初の3サンプルがG1群、残りの3サンプルがG2群の標準正規分布に従う乱数からなるシミュレーションデータです。

乱数発生後に、さらに最初の10% 分についてG1群に相当するところのみ数値を+3している(つまり10% がG1群で高発現というシミュレーションデータを作成している)

以下のコピペで作成しました:

out_f <- "sample23.txt" #出力ファイル名を指定してout_fに格納 param_G1 <- 3 #G1群のサンプル数を指定 param_G2 <- 3 #G2群のサンプル数を指定 param_Ngene <- 10000 #全遺伝子数を指定 param_PDEG <- 0.1 #全遺伝子に占める発現変動遺伝子の割合(PDEG)を指定 #ランダムデータの生成 set.seed(1000) #おまじない(同じ乱数になるようにするため) hoge <- rnorm(param_Ngene*(param_G1+param_G2))#param_Ngene*(param_G1+param_G2)個分の乱数を発生させた結果をhogeに格納 data <- matrix(hoge, nrow=param_Ngene) #param_Ngene*(param_G1+param_G2)個分の要素からなるベクトルhogeを変換して(param_Ngene)個の行数からなる行列を作成した結果をdataに格納 rownames(data) <- paste("gene", 1:param_Ngene, sep="_")#行名を付与 colnames(data) <- c(paste("G1_rep",1:param_G1,sep=""),paste("G2_rep",1:param_G2,sep=""))#列名を付与 #最初の(param_Ngene*param_PDEG)行分についてG1群のデータを+3している head(data) #+3する前のデータの一部を表示させている data[1:(param_Ngene*param_PDEG),1:param_G1] <- data[1:(param_Ngene*param_PDEG),1:param_G1] + 3#+3を実行 head(data) #+3した後のデータの一部を表示させている #ファイルに保存 tmp <- cbind(rownames(data), data) #「rownames情報」と「発現データ」を列方向で結合した結果をtmpに格納 write.table(tmp, out_f, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

Kamei et al., PLoS One, 2013のGSE30533データ(二群間比較用)

最初の5サンプルがG1(Fe_short)群、残りの5サンプルがG2(control)群です。

MAS5法適用後のデータ:data_GSE30533_mas.txt(31,099 probesets×10 samples)

RMA法適用後のデータ:data_GSE30533_rma.txt(31,099 probesets×10 samples)

rmx法適用後のデータ:data_GSE30533_rmx.txt(31,099 probesets×10 samples)

以下のコピペで作成しました:

out_f1 <- "data_GSE30533_mas.txt" #出力ファイル名を指定してout_f1に格納 out_f2 <- "data_GSE30533_rma.txt" #出力ファイル名を指定してout_f2に格納 out_f3 <- "data_GSE30533_rmx.txt" #出力ファイル名を指定してout_f3に格納 param <- "GSE30533" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み library(affy) #パッケージの読み込み library(RobLoxBioC) #パッケージの読み込み #前処理(データ取得) hoge <- ArrayExpress(param, save=F) #paramで指定したIDのCELファイルなどを取得した結果をhogeに格納 #本番(MAS5) eset <- mas5(hoge) #MASを実行し、結果をesetに保存 exprs(eset) <- log(exprs(eset), 2) #底を2として対数変換 data <- exprs(eset) #dataとして取り扱う colnames(data) <- c(paste("G1_", 1:5, sep=""), paste("G2_", 1:5, sep=""))#列名を付与 tmp <- cbind(rownames(data), data) #「rownames情報」と「発現データ」を列方向で結合した結果をtmpに格納 write.table(tmp, out_f1, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存 #本番(RMA) eset <- rma(hoge) #RMAを実行し、結果をesetに保存 data <- exprs(eset) #dataとして取り扱う colnames(data) <- c(paste("G1_", 1:5, sep=""), paste("G2_", 1:5, sep=""))#列名を付与 tmp <- cbind(rownames(data), data) #「rownames情報」と「発現データ」を列方向で結合した結果をtmpに格納 write.table(tmp, out_f2, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存 #本番(RMX) eset <- robloxbioc(hoge) #rmxを実行し、結果をesetに保存 exprs(eset) <- log(exprs(eset), 2) #底を2として対数変換 data <- exprs(eset) #dataとして取り扱う colnames(data) <- c(paste("G1_", 1:5, sep=""), paste("G2_", 1:5, sep=""))#列名を付与 tmp <- cbind(rownames(data), data) #「rownames情報」と「発現データ」を列方向で結合した結果をtmpに格納 write.table(tmp, out_f3, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

10,000 genes×9 samplesからなる3群の遺伝子発現データ。

最初の3サンプルがG1群、残りの3サンプルがG2群の標準正規分布に従う乱数からなるシミュレーションデータです。

乱数発生後に、(1)1-1000行分についてG1群に相当するところのみ数値を+3(つまり1000個がG1群で高発現)

(2)1001-2000行分についてG2群に相当するところのみ数値を+3(つまり1000個がG2群で高発現) (3)2001-3000行分についてG3群に相当するところのみ数値を+3(つまり1000個がG3群で高発現)以下のコピペで作成しました:

out_f <- "sample25.txt" #出力ファイル名を指定してout_fに格納 param_G1 <- 3 #G1群のサンプル数を指定 param_G2 <- 3 #G2群のサンプル数を指定 param_G3 <- 3 #G3群のサンプル数を指定 param_Ngene <- 10000 #全遺伝子数を指定 param_DEG_G1 <- 1:1000 #G1で高発現とする位置を指定 param_DEG_G2 <- 1001:2000 #G2で高発現とする位置を指定 param_DEG_G3 <- 2001:3000 #G3で高発現とする位置を指定 #ランダムデータの生成 data.cl <- c(rep(1, param_G1), rep(2, param_G2), rep(3, param_G3))#G1群を1、G2群を2、G3群を3としたベクトルdata.clを作成 set.seed(1000) #おまじない(同じ乱数になるようにするため) hoge <- rnorm(param_Ngene*length(data.cl))#param_Ngene*length(data.cl)個分の乱数を発生させた結果をhogeに格納 data <- matrix(hoge, nrow=param_Ngene) #ベクトルhogeを変換して(param_Ngene)個の行数からなる行列を作成した結果をdataに格納 rownames(data) <- paste("gene", 1:param_Ngene, sep="_")#行名を付与 colnames(data) <- c(paste("G1_rep",1:param_G1,sep=""), paste("G2_rep",1:param_G2,sep=""), paste("G3_rep",1:param_G3,sep=""))#列名を付与 #DEGを導入 data[param_DEG_G1, data.cl==1] <- data[param_DEG_G1, data.cl==1] + 3#param_DEG_G1行についてG1群のデータを+3 data[param_DEG_G2, data.cl==2] <- data[param_DEG_G2, data.cl==2] + 3#param_DEG_G2行についてG2群のデータを+3 data[param_DEG_G3, data.cl==3] <- data[param_DEG_G3, data.cl==3] + 3#param_DEG_G3行についてG3群のデータを+3 #ファイルに保存 tmp <- cbind(rownames(data), data) #保存したい情報をtmpに格納 write.table(tmp, out_f, sep="\t", append=F, quote=F, row.names=F)#tmpの中身を指定したファイル名で保存

-

23 genes×6 samplesからなる仮想データ。

マイクロアレイデータの図で、高発現のものと低発現のものを疑似色(pseudo-color)で表現するヒートマップを作成するときに、 オプションの挙動を把握するために作成しました。

- GSARパッケージ (Rahmatallah et al., BMC Bioinformatics, 2017) 中で提供されているp53DataSetと同じ2群間比較用データ(17 wild-type samples vs. 33 mutant samples)。

out_f1 <- "sample10.txt" #出力ファイル名を指定してout_f1に格納 out_f2 <- "sample10_cl.txt" #出力ファイル名を指定してout_f2に格納 library(maSigPro) data(data.abiotic) data(edesign.abiotic) write.table(data.abiotic, out_f1, sep = "\t", append=F, quote=F, col.names=T) write.table(edesign.abiotic, out_f2, sep = "\t", append=F, quote=F, col.names=T)

8,655 genes×50 samplesのアレイデータ(sample27.txt; 約7.3MB)

以下のコピペで作成しました:

out_f <- "sample27.txt" #出力ファイル名を指定してout_fに格納 #必要なパッケージをロード library(GSAR) #パッケージの読み込み #発現データの呼び出し data(p53DataSet) #GSARパッケージ中のp53DataSetオブジェクトの呼び出し data <- p53DataSet #オブジェクト名の変更(dataとして取り扱う) #ファイルに保存 tmp <- cbind(rownames(data), data) #保存したい情報をtmpに格納 write.table(tmp, out_f, sep="\t", append=F, quote=F, row.names=F, col.names=T)#tmpの中身を指定したファイル名で保存

イントロ | 発現データ取得 | 公共DBから

遺伝子発現(主にマイクロアレイ)データベースをリストアップします。

一次データベース

- GEO:Barrett et al., Nucleic Acids Res., 2013

- GSE7623(ラット24サンプル, 62MB):Nakai et al., BBB, 2008

- GSE30533(ラット10サンプル, 25MB):Kamei et al., PLoS One, 2013

- GSE2361(ヒト36サンプル, 130MB):Ge et al., Genomics, 2005

- GSE10246(マウス182サンプル, 1.1GB):Lattin et al., Immunome Res., 2008

- GSE1133(ヒトとマウス438サンプル, 1.7GB):Su et al., Proc Natl Acad Sci U S A, 2004

- GSE5364(ヒト341サンプル, 生データなし):Yu et al., PLoS Genet., 2008

- GSE15998(マウス106サンプル, 4.0GB):原著論文はなし?!エクソンアレイ

- ArrayExpress:Rustici et al., Nucleic Acids Res., 2013

- GSE7623(ラット24サンプル, 62MB):Nakai et al., BBB, 2008

- GSE30533(ラット10サンプル, 25MB):Kamei et al., PLoS One, 2013

- GSE2361(ヒト36サンプル, 130MB):Ge et al., Genomics, 2005

- GSE10246(マウス182サンプル, 1.1GB):Lattin et al., Immunome Res., 2008

- GSE1133(リンク先なし):Su et al., Proc Natl Acad Sci U S A, 2004

- GSE5364(ヒト341サンプル, 生データなし):Yu et al., PLoS Genet., 2008

- GSE15998(マウス106サンプル, 4.0GB):原著論文はなし?!エクソンアレイ

イントロ | 発現データ取得 | inSilicoDb(Taminau_2011)

inSilico Db (Coletta et al., Genome Biol., 2012) というヒト(マウス、ラット)のAffymetrixデータからなる二次DBがあります。 この中で提供されている?!GEO ID(基本は"GSE"のID)で取得可能なcurated datasetsを inSilicoDbというRパッケージで取得するやり方を示します。 しかし、運よく存在すればいいのですが、not availableになるケースが多いです。 運がよければfrozen RMA法(fRMA; McCall et al., Biostatistics, 2010)で正規化したデータなどを取得可能です。 2015年5月にgetDataset関数のオプション名がgenesからfeaturesに変わっていたので若干変更しました。 しかし、「 INSILICODB: Please login first to access this dataset. エラー: Stopped because of previous errors」というエラーメッセージが出てしまい、嫌になったので放置することにします。 2013年ごろはうまくうごいたのですがorz...

「ファイル」−「ディレクトリの変更」でファイルを保存したいディレクトリに移動し以下をコピペ。

1. AffymetrixデータGSE30533 (Kamei et al., PLoS One, 2013)のデータを取得したい場合:

2013年8月20日現在、15,923 probesetsになります。

param <- "GSE30533" #入手したいIDを指定 #必要なパッケージをロード library(inSilicoDb) #パッケージの読み込み #本番(データ取得) hoge <- getPlatforms(param) #アレイ(プラットフォーム)情報を取得 eset <- getDataset(param, hoge[[1]], norm="ORIGINAL", features="PROBE")#paramで指定したIDのsubmitterが登録した正規化後のデータ(norm="ORIGINAL")を取得 dim(exprs(eset)) #行数と列数を表示 head(exprs(eset)) #最初の数行を表示

2. AffymetrixデータGSE30533 (Kamei et al., PLoS One, 2013)のデータを取得したい場合:

2013年8月20日現在、以下をやっても"not available"となります。

param <- "GSE30533" #入手したいIDを指定 #必要なパッケージをロード library(inSilicoDb) #パッケージの読み込み #本番(データ取得) hoge <- getPlatforms(param) #アレイ(プラットフォーム)情報を取得 eset <- getDataset(param, hoge[[1]], norm="FRMA", features="PROBE")#paramで指定したIDのfRMA正規化後のデータを取得 dim(exprs(eset)) #行数と列数を表示

3. AffymetrixデータGSE30533 (Kamei et al., PLoS One, 2013)のデータを取得したい場合:

15,923 probeset IDsから10,397 gene symbolsになっていることがわかります。

param <- "GSE30533" #入手したいIDを指定 #必要なパッケージをロード library(inSilicoDb) #パッケージの読み込み #本番(データ取得) hoge <- getPlatforms(param) #アレイ(プラットフォーム)情報を取得 eset <- getDataset(param, hoge[[1]], norm="ORIGINAL", features="GENE")#paramで指定したIDのsubmitterが登録した正規化後のデータ(log2 RMA)を取得 dim(exprs(eset)) #行数と列数を表示 head(exprs(eset)) #最初の数行を表示

イントロ | 発現データ取得 | ArrayExpress(Kauffmann_2009)

マイクロアレイデータベースArrayExpress に登録されているデータをArrayExpressというRパッケージで取得するやり方を示します。 GEO IDでも検索可能であり、CELファイルデータも取得可能、任意のpreprocessing法を適用可能、 などの利点からこのパッケージ経由での利用をお勧めします。

「ファイル」−「ディレクトリの変更」でファイルを保存したいディレクトリに移動し以下をコピペ。

1. AffymetrixデータE-MEXP-1422 (Bourgon et al., PNAS, 2010)のCELファイルを取得し、RMA法(Irizarry et al., Biostatistics, 2003)を実行して得られた発現情報を取得したい場合:

以下のArrayExpress関数のオプションをsave=Fからsave=Tに変更すると、CELファイルなどを含む全データのダウンロードも同時に行ってくれます。 が、そんなことをいちいちやらなくてもReadAffy関数を用いて読み込んだ状態と同じなので直接RMA(Irizarry et al., Biostatistics, 2003)などの任意の正規化法を適用可能です。

out_f <- "data_rma.txt" #出力ファイル名を指定してout_fに格納 param <- "E-MEXP-1422" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み library(affy) #パッケージの読み込み #前処理(データ取得) hoge <- ArrayExpress(param, save=F) #paramで指定したIDのデータを取得した結果をhogeに格納 #本番 eset <- rma(hoge) #RMAを実行し、結果をesetに保存 #ファイルに保存 write.exprs(eset, file=out_f) #結果を指定したファイル名で保存

2. AffymetrixデータGSE30533 (Kamei et al., PLoS One, 2013)のCELファイルを取得したい場合:

GSE30533というID自体はGEOのものですが、比較的最近のデータ?!についてはGEOとArrayExpress間で共有しているようです。ちなみにArrayExpress内でのIDは"E-GEOD-30533"となっています。

param <- "GSE30533" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み #前処理(データ取得) hoge <- getAE(param, type="raw", extract=F)#paramで指定したIDの生データをダウンロード("extract=T"にすると圧縮ファイルを自動的に解凍してくれますが大量のファイル数になります...)

3. AffymetrixデータGSE7623 (Nakai et al., BBB, 2008)のCELファイルを取得したい場合:

param <- "GSE7623" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み #前処理(データ取得) hoge <- getAE(param, type="raw", extract=F)#paramで指定したIDの生データをダウンロード("extract=T"にすると圧縮ファイルを自動的に解凍してくれますが大量のファイル数になります...)

4. AgilentデータGSE7866 (Tesar et al., Nature, 2007)の生ファイルを取得したい場合:

生データファイルが存在しないので、adf, sdrf, and idf形式の計3ファイルしかダウンロードされない例です。

param <- "GSE7866" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み #前処理(データ取得) hoge <- getAE(param, type="raw", extract=F)#paramで指定したIDの生データをダウンロード("extract=T"にすると圧縮ファイルを自動的に解凍してくれますが大量のファイル数になります...)

5. AgilentデータGSE10417 (Chikahisa et al., Endocrinology, 2008)の生ファイルを取得したい場合:

GEOには存在するが、ArrayExpressからはGSE IDで取得できない例です。E-GEOD-10417で検索してもだめです。

param <- "GSE10417" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み #前処理(データ取得) hoge <- getAE(param, type="raw", extract=F)#paramで指定したIDの生データをダウンロード("extract=T"にすると圧縮ファイルを自動的に解凍してくれますが大量のファイル数になります...)

6. AffymetrixデータGSE781 (Lenburg et al., BMC Cancer, 2003)のCELファイルを取得したい場合:

GSE781は2種類のアレイ(GPL96 and GPL97)を使っています。ファイルサイズが大きい(全部で1GB程度?!)ので注意してください。

param <- "GSE781" #入手したいIDを指定 #必要なパッケージをロード library(ArrayExpress) #パッケージの読み込み #前処理(データ取得) hoge <- getAE(param, type="raw", extract=F)#paramで指定したIDの生データをダウンロード("extract=T"にすると圧縮ファイルを自動的に解凍してくれますが大量のファイル数になります...)

イントロ | 発現データ取得 | GEOquery (Davis_2007)

公共DBGene Expression Omnibus (GEO)に登録されているデータをGEOqueryというRパッケージを用いてゲットするやり方を示します。

が、このパッケージの利用はおすすめできません。理由は、発現データがどんな正規化法(RMAとやMBEIなど)で得られたものかや対数変換の有無などがそのIDのsubmitter依存(inconsistent preprocessing)だからです(Taminau et al., BMC Bioinformatics, 2012)。

「ファイル」−「ディレクトリの変更」でファイルを保存したいディレクトリに移動し以下をコピペ。

1. AffymetrixデータGSE7623 (Nakai et al., BBB, 2008)のプローブレベルデータファイル(.CEL)を入手したい場合:

param <- "GSE7623" #入手したいGEO IDを指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #本番 getGEOSuppFiles(param) #指定したGEO IDのサプリメントファイル(CELファイルに相当)をダウンロード

2. AffymetrixデータGSE7623 (Nakai et al., BBB, 2008)の発現情報を取得したい場合:

GSE7623は1種類のアレイ(GPL1355)しか使っていないので、1つのファイルのみ生成されます。

param1 <- "GSE7623" #入手したいGEO IDを指定 param2 <- "hoge2_" #出力ファイル名の最初の部分を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 eset <- getGEO(param1) #指定したGEO IDのデータを取得した結果をesetに格納 sapply(eset, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(eset, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 write.exprs(eset[[i]], file=out_f) #outの中身を指定したファイル名で保存。 }

3. AffymetrixデータGSE781 (Lenburg et al., BMC Cancer, 2003)の発現情報を取得したい場合:

GSE781は2種類のアレイ(GPL96 and GPL97)を使っているので、2つのファイルが生成されます。

param1 <- "GSE781" #入手したいGEO IDを指定 param2 <- "hoge3_" #出力ファイル名の最初の部分を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 eset <- getGEO(param1) #指定したGEO IDのデータを取得した結果をesetに格納 sapply(eset, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(eset, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 write.exprs(eset[[i]], file=out_f) #outの中身を指定したファイル名で保存。 }

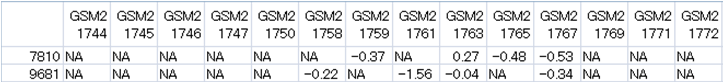

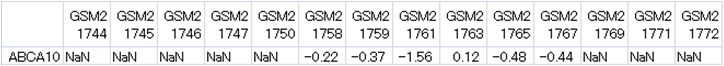

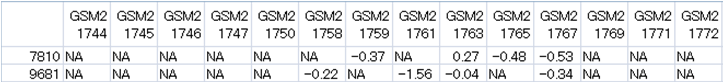

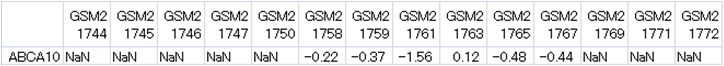

4. two-color AgilentデータGSE1322 (Hayashi et al., Psychother. Psychosom., 2006)を入手したい場合:

詳細はGEOのGSE1322でわかりますが、ここで入手している発現データ

(全部糖尿病患者のperipheral bloodサンプル)はいわゆるlog ratioです。具体的にはlog2(Cy5/Cy3)で、

GSM21742: (面白い話を聞いた患者ID1)log2(After/Before) GSM21743: (面白い話を聞いた患者ID2)log2(After/Before) GSM21744: (面白い話を聞いた患者ID3)log2(After/Before) GSM21745: (面白い話を聞いた患者ID5)log2(After/Before) GSM21746: (面白い話を聞いた患者ID6)log2(After/Before) GSM21747: (面白い話を聞いた患者ID7)log2(After/Before) GSM21748: (面白い話を聞いた患者ID8)log2(After/Before) GSM21749: (面白い話を聞いた患者ID9)log2(After/Before) GSM21750: (面白い話を聞いた患者ID10)log2(After/Before) GSM21751: (面白い話を聞いた患者ID11)log2(After/Before) GSM21752: (面白い話を聞いた患者ID13)log2(After/Before) GSM21753: (面白い話を聞いた患者ID14)log2(After/Before) GSM21758: (面白い話を聞いた患者ID16)log2(After/Before) GSM21759: (面白い話を聞いた患者ID17)log2(After/Before) GSM21761: (退屈な講義を聞いた患者ID3)log2(After/Before) GSM21763: (退屈な講義を聞いた患者ID5)log2(After/Before) GSM21765: (退屈な講義を聞いた患者ID6)log2(After/Before) GSM21767: (退屈な講義を聞いた患者ID7)log2(After/Before) GSM21769: (退屈な講義を聞いた患者ID10)log2(After/Before) GSM21771: (退屈な講義を聞いた患者ID16)log2(After/Before) GSM21772: (退屈な講義を聞いた患者ID17)log2(After/Before)

のデータです(私の理解が間違ってなければ...)。

param1 <- "GSE1322" #入手したいGEO IDを指定 param2 <- "hoge4_" #出力ファイル名の最初の部分を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 eset <- getGEO(param1) #指定したGEO IDのデータを取得した結果をesetに格納 sapply(eset, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(eset, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 write.exprs(eset[[i]], file=out_f) #outの中身を指定したファイル名で保存。 }

5. AffymetrixデータGSE30533 (Kamei et al., PLoS One, 2013)の発現情報を取得したい場合:

GSE30533は1種類のアレイ(GPL1355)しか使っていないので、1つのファイルのみ生成されます。

param1 <- "GSE30533" #入手したいGEO IDを指定 param2 <- "hoge5_" #出力ファイル名の最初の部分を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 eset <- getGEO(param1) #指定したGEO IDのデータを取得した結果をesetに格納 sapply(eset, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(eset, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 write.exprs(eset[[i]], file=out_f) #outの中身を指定したファイル名で保存。 }

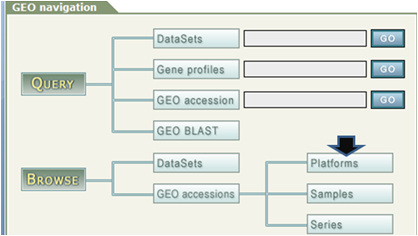

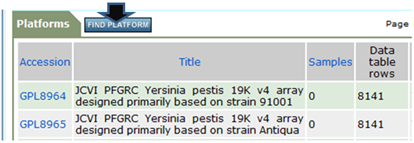

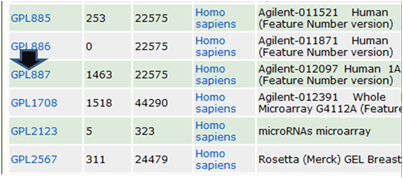

イントロ | アノテーション情報取得 | 公共DB(GEO)から

公共マイクロアレイDBのGene Expression Omnibus (GEO)からアノテーション情報を取得するやり方を紹介します。

-

Gene Expression Omnibus (GEO)のページで「Platforms」をクリック

-

「FIND PLATFORM」をクリック

-

アノテーションを得たいメーカーおよび生物種などを指定してもう一度「FIND PLATFORM」をクリック

-

いくつかリストアップされる候補の中から目的のチップ(例ではAgilent Human 1A (V2))

につけられているPlatform ID (GPLXXX; 例ではGPL887)をクリック

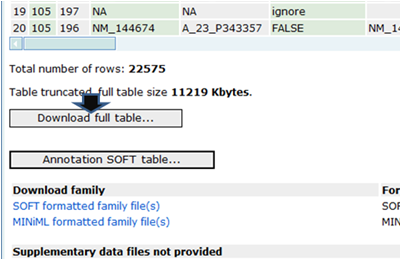

-

表示されたページの一番したのほうで「Download full table」

(または「Annotation SOFT table」)をクリックして得られるファイル(GPL887-5640.txt)を保存

-

機能解析(GSEA周辺)を行いたいときには、以下の作業を行っておいてください。

(i)エクセルでGPL887-5640.txtを開き

(ii)最終的にIDとGene symbolだけからなるGPL887-5640_symbol.txtのようなファイルを作成しておけば、 前処理 | ID変換 | probe ID --> gene symbolや前処理 | ID変換 | 同じ遺伝子名を持つものをまとめるなどの読み込みファイルとして利用可能です。

イントロ | アノテーション情報取得 | GEOquery (Davis_2007)

公共DBGene Expression Omnibus (GEO)に登録されているアレイ(Platform)のアノテーション情報をGEOqueryというRパッケージを用いてゲットするやり方を示します。

「ファイル」−「ディレクトリの変更」でファイルを保存したいディレクトリに移動し以下をコピペ。

1. Affymetrix Rat Genome 230 2.0 Array (GPL1355)のアノテーション情報を知りたい場合:

out_f <- "hoge1.txt" #出力ファイル名を指定してout_fに格納 param <- "GPL1355" #入手したいGEO IDを指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 data <- getGEO(param) #指定したGEO IDのデータを取得 #本番 out <- data@dataTable@table #アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存

2. "GSE"から始まるIDをたよりにアレイのID情報を内部的に入手してアノテーション情報を取得したい場合:

GSE7623 (Nakai et al., BBB, 2008)は1種類のアレイ(GPL1355)しか使っていないので、1つのファイルのみ生成されます。

param1 <- "GSE7623" #入手したいGEO IDを指定 param2 <- "hoge2_" #出力ファイル名の最初の部分を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 data <- getGEO(param1) #指定したGEO IDのデータを取得 sapply(data, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(data, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 out <- data[[i]]@featureData@data #アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存 }

3. "GSE"から始まるIDをたよりにアレイのID情報を内部的に入手してアノテーション情報を取得したい場合:

GSE7623 (Nakai et al., BBB, 2008)は1種類のアレイ(GPL1355)しか使っていないので、1つのファイルのみ生成されます。 出力ファイルの情報に相当するoutオブジェクト中の、自分がほしいprobe ID列とgene symbol列が1列目と 11列目に存在することがあらかじめ分かっているという前提です。colnames(out)でわかります。 アノテーション情報のバージョンが異なりうるため若干違うかもしれませんがhoge3_GPL1355.txtと酷似したものができていると思います。 Windows10上のRver. 3.3.2にて例題3の動作確認済み(2017/03/08)。

param1 <- "GSE7623" #入手したいGEO IDを指定 param2 <- "hoge3_" #出力ファイル名の最初の部分を指定 param_posi <- c(1, 11) #outオブジェクト中のID列とgene symbol列の位置情報を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 data <- getGEO(param1) #指定したGEO IDのデータを取得 sapply(data, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(data, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 out <- data[[i]]@featureData@data #アノテーション情報抽出結果をoutに格納 colnames(out) #確認してるだけです out <- out[,param_posi] #サブセットを抽出 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存 }

4. "GSE"から始まるIDをたよりにアレイのID情報を内部的に入手してアノテーション情報を取得したい場合:

GSE781は2種類のアレイ(GPL96とGPL97)を使っているので、2つのファイルが生成されます。

param1 <- "GSE781" #入手したいGEO IDを指定 param2 <- "hoge4_" #出力ファイル名の最初の部分を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 data <- getGEO(param1) #指定したGEO IDのデータを取得 sapply(data, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(data, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 out <- data[[i]]@featureData@data #アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存 }

5. Affymetrix Human Transcriptome Array (Gene level: GPL17586)のアノテーション情報を知りたい場合:

out_f <- "hoge5.txt" #出力ファイル名を指定してout_fに格納 param <- "GPL17586" #入手したいGEO IDを指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 data <- getGEO(param) #指定したGEO IDのデータを取得 #本番 out <- data@dataTable@table #アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存

6. "GSE"から始まるIDをたよりにアレイのID情報を内部的に入手してアノテーション情報を取得したい場合:

GSE1322(Hayashi et al., Psychother Psychosom, 2006)は1種類のアレイ(GPL887)しか使っていないので、1つのファイルのみ生成されます。 出力ファイルの情報に相当するoutオブジェクト中の、自分がほしいprobe ID列とgene symbol列が1列目と 10列目に存在することがあらかじめ分かっているという前提です。colnames(out)でわかります。 アノテーション情報のバージョンが異なりうるため若干違うかもしれませんがhoge6_GPL887.txtと酷似したものができていると思います。

param1 <- "GSE1322" #入手したいGEO IDを指定 param2 <- "hoge6_" #出力ファイル名の最初の部分を指定 param_posi <- c(1, 10) #outオブジェクト中のID列とgene symbol列の位置情報を指定 #必要なパッケージをロード library(GEOquery) #パッケージの読み込み #前処理 data <- getGEO(param1) #指定したGEO IDのデータを取得 sapply(data, annotation) #用いられたアレイ情報(GPL ID)を表示 #本番 hoge <- sapply(data, annotation) #用いられたアレイ情報(GPL ID)をhogeに格納 for(i in 1:length(hoge)){ #hogeの要素数(用いられたアレイ数)分だけループを回す out_f <- paste(param2, hoge[i], ".txt", sep="")#出力ファイル名を作成した結果をout_fに格納 out <- data[[i]]@featureData@data #アノテーション情報抽出結果をoutに格納 colnames(out) #確認してるだけです out <- out[,param_posi] #サブセットを抽出 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存 }

イントロ | アノテーション情報取得 | Rのパッケージ*.dbから

Affymetrix, Agilent, Illumina製など様々な製造メーカーの製品のアノテーション情報を取得するやり方を示します。 数多くの製品(約200 chips)がありますので、詳しくは「全パッケージリスト(All Packages)」中の 「ChipName」をご覧ください。 ただし、Rで提供されていないものも多数ありますのでご注意ください。(例:Agilent-014850 Whole Human Genome Microarray 4x44K G4112F; GPL6480; 2013年8月14日調べ)

「ChipName」のリストを眺めることで、例えばNakai et al., BBB, 2008で用いられた 「Affymetrix Rat Genome 230 2.0 Array」のアノテーション情報はrat2302.dbに含まれていることが分かります。 このようにして、適宜自分が欲しいチップのアノテーション情報がどのような名前で入手できるのか調べた上で、以下のようにします。1. Affymetrix Rat Genome 230 2.0 Array (rat2302.db; GPL1355)の場合:

out_f <- "hoge1.txt" #出力ファイル名を指定してout_fに格納 param1 <- "rat2302.db" #パッケージ名を指定 param2 <- c("REFSEQ", "SYMBOL", "GENENAME")#欲しいアノテーション情報を指定(記述可能なリストは以下のkeytypes(dbname)から取得可能) #必要なパッケージのインストール(利用したいパッケージが既に存在していれば2回目以降は必要なし) source("http://bioconductor.org/biocLite.R")#指定したパッケージのインストール biocLite(param1, suppressUpdates=TRUE) #指定したパッケージのインストール #必要なパッケージをロード library(param1, character.only=T) #指定したパッケージの読み込み #前処理(抽出可能な情報のリストアップおよびキーを表示) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) cols(hoge) #hoge中に含まれている情報を表示 keytypes(hoge) #hogeから実際に使用するキーを表示 param_key <- keys(hoge, keytype="PROBEID")#param1で指定したものをキーにしている #本番 out <- select(hoge, keys=param_key, keytype="PROBEID", columns=param2)#アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存

2. Affymetrix Rat Genome 230 2.0 Array (rat2302.db; GPL1355)でプローブIDとgene symbolの対応情報のみ欲しい場合:

out_f <- "hoge2.txt" #出力ファイル名を指定してout_fに格納 param1 <- "rat2302.db" #パッケージ名を指定 param2 <- "SYMBOL" #欲しいアノテーション情報を指定(記述可能なリストは以下のkeytypes(dbname)から取得可能) #必要なパッケージのインストール(利用したいパッケージが既に存在していれば2回目以降は必要なし) source("http://bioconductor.org/biocLite.R")#指定したパッケージのインストール biocLite(param1, suppressUpdates=TRUE) #指定したパッケージのインストール #必要なパッケージをロード library(param1, character.only=T) #param1で指定したパッケージの読み込み #前処理(抽出可能な情報のリストアップおよびキーを表示) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) cols(hoge) #hoge中に含まれている情報を表示 keytypes(hoge) #hogeから実際に使用するキーを表示 param_key <- keys(hoge, keytype="PROBEID")#param1で指定したものをキーにしている #本番 out <- select(hoge, keys=param_key, keytype="PROBEID", columns=param2)#アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存

3. Illumina MouseWG-6 v2.0 Expression BeadChip (illuminaMousev2.db; GPL6887)の場合:

out_f <- "hoge3.txt" #出力ファイル名を指定してout_fに格納 param1 <- "illuminaMousev2.db" #パッケージ名を指定 param2 <- c("REFSEQ", "SYMBOL", "GENENAME", "CHRLOC", "ENSEMBLTRANS")#欲しいアノテーション情報を指定(記述可能なリストは以下のkeytypes(dbname)から取得可能) #必要なパッケージのインストール(利用したいパッケージが既に存在していれば2回目以降は必要なし) source("http://bioconductor.org/biocLite.R")#指定したパッケージのインストール biocLite(param1, suppressUpdates=TRUE) #指定したパッケージのインストール #必要なパッケージをロード library(param1, character.only=T) #param1で指定したパッケージの読み込み #前処理(抽出可能な情報のリストアップおよびキーを表示) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) cols(hoge) #hoge中に含まれている情報を表示 keytypes(hoge) #hogeから実際に使用するキーを表示 param_key <- keys(hoge, keytype="PROBEID")#param1で指定したものをキーにしている #本番 out <- select(hoge, keys=param_key, keytype="PROBEID", columns=param2)#アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存

4. Agilent Whole Human Genome Oligo Microarray G4112A (hgug4112a.db; GPL1708)の場合:

out_f <- "hoge4.txt" #出力ファイル名を指定してout_fに格納 param1 <- "hgug4112a.db" #パッケージ名を指定 param2 <- c("REFSEQ", "SYMBOL") #欲しいアノテーション情報を指定(記述可能なリストは以下のkeytypes(dbname)から取得可能) #必要なパッケージのインストール(利用したいパッケージが既に存在していれば2回目以降は必要なし) source("http://bioconductor.org/biocLite.R")#指定したパッケージのインストール biocLite(param1, suppressUpdates=TRUE) #指定したパッケージのインストール #必要なパッケージをロード library(param1, character.only=T) #param1で指定したパッケージの読み込み #前処理(抽出可能な情報のリストアップおよびキーを表示) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) cols(hoge) #hoge中に含まれている情報を表示 keytypes(hoge) #hogeから実際に使用するキーを表示 param_key <- keys(hoge, keytype="PROBEID")#param1で指定したものをキーにしている #本番 out <- select(hoge, keys=param_key, keytype="PROBEID", columns=param2)#アノテーション情報抽出結果をoutに格納 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#outの中身を指定したファイル名で保存

イントロ | プローブ配列情報取得 | Rのパッケージから

Affymetrix, Agilent, Illumina製など様々な製造メーカーの製品のプローブ配列情報を取得するやり方を示します。 数多くの製品(約200 chips)がありますので、詳しくは「全パッケージリスト(All Packages)」中の 「ChipName」をご覧ください。 ただし、Rで提供されていないものも多数ありますのでご注意ください。(例:Agilent-014850 Whole Human Genome Microarray 4x44K G4112F; GPL6480; 2013年8月14日調べ)

「ChipName」のリストを眺めることで、例えばNakai et al., BBB, 2008で用いられた 「Affymetrix Rat Genome 230 2.0 Array」のプローブ配列情報はrat2302probeに含まれていることが分かります。 このようにして、適宜自分が欲しいチップのプローブ配列情報がどのような名前で入手できるのか調べた上で、以下のようにします。1. Affymetrix Human Genome U133 Plus 2.0 Array (hgu133plus2probe; GPL570)の場合:

out_f <- "hoge1.txt" #出力ファイル名を指定してout_fに格納 param <- "hgu133plus2probe" #パッケージ名を指定 #必要なパッケージをロード library(param, character.only=T) #paramで指定したパッケージの読み込み #前処理(統一的なオブジェクト名に変更しているだけ) hoge <- eval(parse(text=param)) #オブジェクト名の変更(hogeとして取り扱う) #本番(ファイルに保存) write.table(hoge, out_f, sep="\t", append=F, quote=F, row.names=F)#hogeの中身を指定したファイル名で保存

2. Affymetrix Human Genome U133 Plus 2.0 Array (hgu133plus2probe; GPL570)の場合:

(指定したプローブセットIDのみ抽出するやり方です)

out_f <- "hoge2.txt" #出力ファイル名を指定してout_fに格納 param1 <- "hgu133plus2probe" #パッケージ名を指定 param2 <- "1552263_at" #プローブセットID情報を指定 #必要なパッケージをロード library(param1, character.only=T) #param1で指定したパッケージの読み込み #前処理(統一的なオブジェクト名に変更しているだけ) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) #本番(フィルタリング) obj <- is.element(as.character(hoge$Probe.Set.Name), param2)#条件を満たすかどうかを判定した結果をobjに格納 out <- hoge[obj,] #objがTRUEとなる行のみ抽出した結果をoutに格納 #ファイルに保存 write.table(out, out_f, sep="\t", append=F, quote=F, row.names=F)#hogeの中身を指定したファイル名で保存

3. Affymetrix Human Genome U133 Plus 2.0 Array (hgu133plus2probe; GPL570)の場合:

(指定したプローブセットIDのみmulti-FASTA形式で保存するやり方です)

out_f <- "hoge3.txt" #出力ファイル名を指定してout_fに格納 param1 <- "hgu133plus2probe" #パッケージ名を指定 param2 <- "1552263_at" #プローブセットID情報を指定 #必要なパッケージをロード library(Biostrings) #パッケージの読み込み library(param1, character.only=T) #param1で指定したパッケージの読み込み #前処理(統一的なオブジェクト名に変更しているだけ) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) #本番(フィルタリング) obj <- is.element(as.character(hoge$Probe.Set.Name), param2)#条件を満たすかどうかを判定した結果をobjに格納 out <- hoge[obj,] #objがTRUEとなる行のみ抽出した結果をoutに格納 #後処理(FASTA形式に変換) fasta <- DNAStringSet(out$sequence) #塩基配列情報をDNAStringSetオブジェクトとしてfastaに格納 description <- paste(out$Probe.Set.Name, out$Probe.Interrogation.Position, sep=".")#description部分を作成 names(fasta) <- description #description行に相当する記述を追加している #ファイルに保存 writeXStringSet(fasta, file=out_f, format="fasta", width=50)#fastaの中身を指定したファイル名で保存

4. Affymetrix Rat Genome 230 2.0 Array (rat2302probe; GPL1355)の場合:

(指定したプローブセットIDのみmulti-FASTA形式で保存するやり方です)

out_f <- "hoge4.txt" #出力ファイル名を指定してout_fに格納 param1 <- "rat2302probe" #パッケージ名を指定 param2 <- "1369078_at" #プローブセットID情報を指定 #必要なパッケージをロード library(Biostrings) #パッケージの読み込み library(param1, character.only=T) #param1で指定したパッケージの読み込み #前処理(統一的なオブジェクト名に変更しているだけ) hoge <- eval(parse(text=param1)) #オブジェクト名の変更(hogeとして取り扱う) #本番(フィルタリング) obj <- is.element(as.character(hoge$Probe.Set.Name), param2)#条件を満たすかどうかを判定した結果をobjに格納 out <- hoge[obj,] #objがTRUEとなる行のみ抽出した結果をoutに格納 #後処理(FASTA形式に変換) fasta <- DNAStringSet(out$sequence) #塩基配列情報をDNAStringSetオブジェクトとしてfastaに格納 description <- paste(out$Probe.Set.Name, out$Probe.Interrogation.Position, sep=".")#description部分を作成 names(fasta) <- description #description行に相当する記述を追加している #ファイルに保存 writeXStringSet(fasta, file=out_f, format="fasta", width=50)#fastaの中身を指定したファイル名で保存

イントロ | トランスクリプトーム配列取得 | biomaRt(Durinck_2009)

biomaRtというRパッケージ(Durinck et al., Nat Protoc., 2009)を用いて、 各種アレイ上に搭載されているプローブセットに対応する転写物(トランスクリプトーム)配列を取得するやり方を示します。

「ファイル」−「ディレクトリの変更」でファイルを保存したいディレクトリに移動し以下をコピペ。

1. Affymetrix Rat Genome 230 2.0 Array (GPL1355)に搭載されている転写物のcDNA配列を取得したい場合:

ラット(Rattus norvegicus)アレイだとわかっているので以下のようなオプションを指定しています。

out_f <- "hoge1.txt" #出力ファイル名を指定してout_fに格納 param_dataset <- "rnorvegicus_gene_ensembl"#データセット名を指定(「listDatasets(useMart("ensembl"))」にリストアップされているものを指定可能) param_attribute <- "affy_rat230_2" #配列を取得したい属性名を指定(「listAttributes(mart)」にリストアップされているものを指定可能) param_seqtype <- "cdna" #配列のタイプを指定(cdna, peptide, 3utr, 5utr, genomicのいずれかが指定可能です) #必要なパッケージをロード library(biomaRt) #パッケージの読み込み #前処理(IDリスト情報を取得) mart <- useMart("ensembl",dataset=param_dataset)#データベース名("ensembl")とparam_datasetで指定したデータセット名を与えてmartに格納 hoge <- getBM(attributes=param_attribute, filters="", values="", mart=mart)#指定したIDリスト取得結果をhogeに格納 head(hoge) #確認してるだけです length(hoge) #ID数を表示 #本番(配列取得) out <- getSequence(id=hoge, type=param_attribute, seqType=param_seqtype, mart=mart)#指定したパラメータで配列取得した結果をoutに格納 dim(out) #配列数がID数に比べて若干少ないのは複数のプローブセットが同じ転写物由来なためです。 #ファイルに保存 exportFASTA(out, file=out_f) #outの中身を指定したファイル名で保存

2. Affymetrix Rat Genome 230 2.0 Array (GPL1355)に搭載されている転写物の5' UTR配列を取得したい場合:

上で得られたファイルと比較すると、転写開始点の手前までの配列だけになっていることがわかります。

out_f <- "hoge2.txt" #出力ファイル名を指定してout_fに格納 param_dataset <- "rnorvegicus_gene_ensembl"#データセット名を指定(「listDatasets(useMart("ensembl"))」にリストアップされているものを指定可能) param_attribute <- "affy_rat230_2" #配列を取得したい属性名を指定(「listAttributes(mart)」にリストアップされているものを指定可能) param_seqtype <- "5utr" #配列のタイプを指定(cdna, peptide, 3utr, 5utr, genomicのいずれかが指定可能です) #必要なパッケージをロード library(biomaRt) #パッケージの読み込み #前処理(IDリスト情報を取得) mart <- useMart("ensembl",dataset=param_dataset)#データベース名("ensembl")とparam_datasetで指定したデータセット名を与えてmartに格納 hoge <- getBM(attributes=param_attribute, filters="", values="", mart=mart)#指定したIDリスト取得結果をhogeに格納 head(hoge) #確認してるだけです length(hoge) #ID数を表示 #本番(配列取得) out <- getSequence(id=hoge, type=param_attribute, seqType=param_seqtype, mart=mart)#指定したパラメータで配列取得した結果をoutに格納 dim(out) #配列数を表示 #ファイルに保存 exportFASTA(out, file=out_f) #outの中身を指定したファイル名で保存

3. Affymetrix Rat Genome 230 2.0 Array (GPL1355)に搭載されている特定のプローブセット("1369078_at")のcDNA配列を取得したい場合:

param_valueという追加オプションがあるだけです。